Bilan du concours pilote de bourses de recherche du printemps 2013

Table des matières

- Introduction

- Aperçu du concours

- Méthodes

- Résumé des résultats

- Conclusion et résumé des changements découlant du concours pilote

- Annexe 1 : Résultats détaillés du sondage

- Annexe 2 : Sondage à l'intention des évaluateurs pour les bourses de recherche

Introduction

Le succès de la transition vers la nouvelle série de programmes ouverts et le nouveau processus d'évaluation par les pairs repose surtout sur l'efficacité de la mise à l'essai de la fonctionnalité des éléments conceptuels de l'évaluation par les pairs avant leur mise en œuvre complète. Lorsque chacune des études pilotes sera terminée, nous avons l'intention d'en rendre les conclusions accessibles afin de contribuer à l'ensemble de la littérature sur l'évaluation par les pairs et la conception des programmes.

La mise à l'essai des éléments conceptuels de l'évaluation par les pairs permettra aux IRSC d'ajuster et de peaufiner les systèmes et les processus afin de faciliter la tâche aux candidats et aux évaluateurs. Afin de déterminer les aspects à améliorer, les IRSC sondent les candidats, le personnel des IRSC, les établissements et les membres des comités d'évaluation par les pairs pour obtenir leurs commentaires.

Il importe de noter que, durant les concours pilotes, les IRSC s'assureront que la qualité du processus d'évaluation par les pairs n'est pas compromise et que chaque candidat bénéficie d'une évaluation objective, transparente et de haute qualité.

Remarque : Les IRSC utilisent aussi des données provenant du concours pilote dont il est question ici pour valider le nombre optimal d'évaluateurs à affecter à une demande et déterminer le nombre de fois où les évaluateurs modifient leurs évaluations après avoir vu celles des autres évaluateurs ou avoir participé à une discussion en ligne asynchrone. Ces analyses sont effectuées séparément et leurs résultats seront communiqués ultérieurement.

Aperçu du concours

Le programme de bourses de recherche a été choisi pour cet essai parce qu'un processus d'évaluation à distance y est utilisé depuis un certain nombre d'années et que le nombre de demandes reçues est considérable. Par conséquent, la fonctionnalité mise à l'essai dans ce concours a permis non seulement de tester des éléments conceptuels de l'évaluation par les pairs, mais elle a aussi représenté une amélioration du processus existant d'évaluation par les pairs. Pour ce concours, 608 demandes ont été évaluées par 209 évaluateurs.

Dans ce premier concours pilote, un certain nombre d'éléments conceptuels du programme sont demeurés inchangés :

- les fonds disponibles

- les critères d'évaluation

- le processus d'assignation des demandes aux évaluateurs

- le processus des décisions de financement

- l'échelle de cotation

- la structure des demandes

Les objectifs du concours pilote étaient de mettre à l'essai les fonctionnalités proposées et les processus relatifs à l'évaluation à distance et à la discussion en ligne asynchrone. Les éléments conceptuels suivants du plan de projet proposé ont été mis à l'essai :

- Augmentation du nombre d'évaluateurs par demande (qui passe de 2 à 3)

- Fonctionnalité de l'évaluation à distance (présenter les évaluations préliminaires et finales à distance)

- Discussion en ligne asynchrone

Remarque : La qualité des évaluations individuelles n'a pas été examinée dans ce projet.

| Élément conceptuel | Objectifs | Description |

|---|---|---|

| Nombre plus grand d'évaluateurs par demande |

|

|

| Évaluation à distance - Présentation des évaluations préliminaires et finales |

|

|

| Discussion en ligne asynchrone |

|

|

Il est important de prendre note des limites du concours pilote. Le programme de bourses de recherche est un programme de bourses de formation, et il existe donc certaines différences notables dans sa conception comparativement à celle d'un programme de subventions. Notamment, les demandes sont classées dans une de cinq catégories en fonction de la formation du candidat et du projet de recherche proposé. Les évaluateurs désignés dans chaque catégorie sont ensuite choisis aléatoirement pour évaluer les demandes dans leurs catégories respectives. Cette façon de procéder diffère de l'affectation plus complexe fondée sur l'expertise qui est faite dans la plupart des programmes de subventions des IRSC.

Méthodes

L'évaluation par les pairs a été effectuée du 2 avril au 10 mai 2013 par 209 évaluateurs. Les évaluateurs ont eu trois semaines pour participer à la discussion en ligne asynchrone avant de présenter leurs évaluations définitives. Le 15 mai 2013, après la clôture du processus d'évaluation, une invitation à remplir un sondage a été envoyée directement aux 209 évaluateurs à l'aide du module Invitation de FluidSurveys. Une adresse URL distincte a été fournie à chacun des participants pour leur permettre de s'interrompre, de sauvegarder leurs réponses et de continuer de répondre au questionnaire à leur convenance. Les IRSC ont suivi les taux de réponse et ont envoyé deux rappels par courriel pour s'assurer que le taux ciblé serait atteint.

Les candidats n'ont pas été sondés dans le présent concours pilote, car les changements ne touchaient que les évaluateurs. Ils l'ont été dans le deuxième concours pilote sur les bourses de recherche à l'automne 2013, des améliorations à la demande structurée étant apportées à ce moment.

Résumé des résultats

L'objectif du premier sondage (Annexe 2 : Sondage à l'intention des évaluateurs pour les bourses de recherche) était d'évaluer avec les évaluateurs le processus amélioré d'évaluation à distance dans RechercheNet, soit :

- leur expérience avec RechercheNet;

- l'utilité d'avoir accès aux évaluations des autres évaluateurs;

- l'utilité de l'outil de discussion en ligne asynchrone.

Les résultats détaillés du sondage et un résumé des principales conclusions et observations se trouvent à l'annexe 1.

Le taux de réponse au sondage de 70 % a été supérieur à la cible. Toutefois, le faible nombre d'évaluateurs limitera l'analyse statistique possible. Nous continuerons de bâtir la base de données au fil des concours pilotes et des sondages à venir. Quoi qu'il en soit, les résultats du premier sondage sont positifs dans le contexte du concours. Les répondants ont indiqué un certain nombre d'aspects à améliorer, et plusieurs des améliorations suggérées ont été apportées dès les projets pilotes suivants.

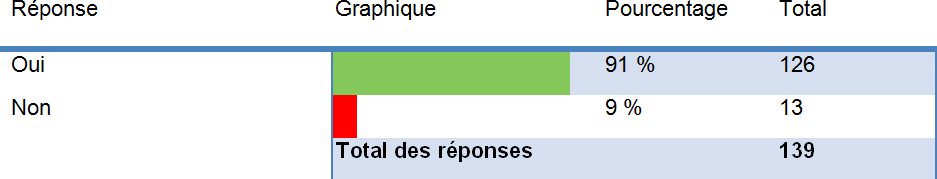

i. Expérience de RechercheNet

La très vaste majorité (91 %) des évaluateurs ont trouvé la technologie RechercheNet facile à utiliser, mais des conseils ont quand même été fournis pour améliorer l'interface du système. Dans l'ensemble, 84 % des répondants ont indiqué que le processus d'évaluation par les pairs avait été efficient. Quelques problèmes techniques se sont posés, et un certain nombre d'améliorations ont été proposées. Nombre de ces améliorations ont été apportées dans les concours pilotes ultérieurs (phase 2 du concours pilote sur les bourses de recherche et concours pilote de subventions sur la synthèse des connaissances), comme il est indiqué dans la conclusion et le résumé des changements du présent bilan.

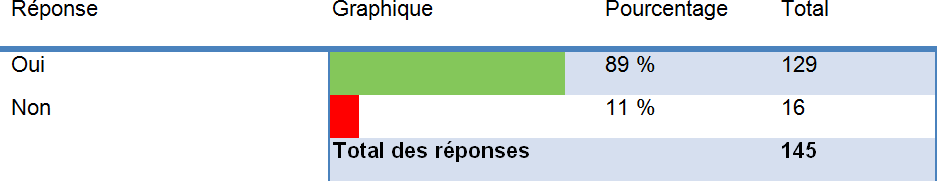

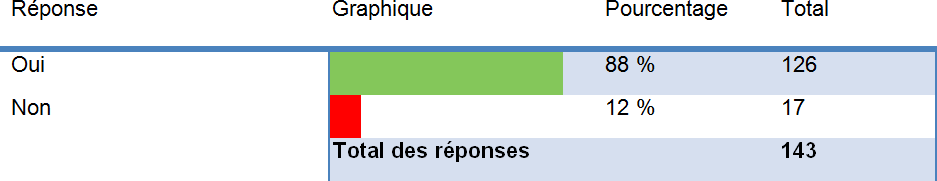

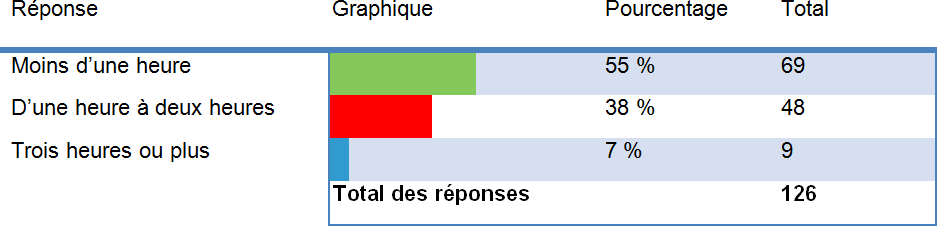

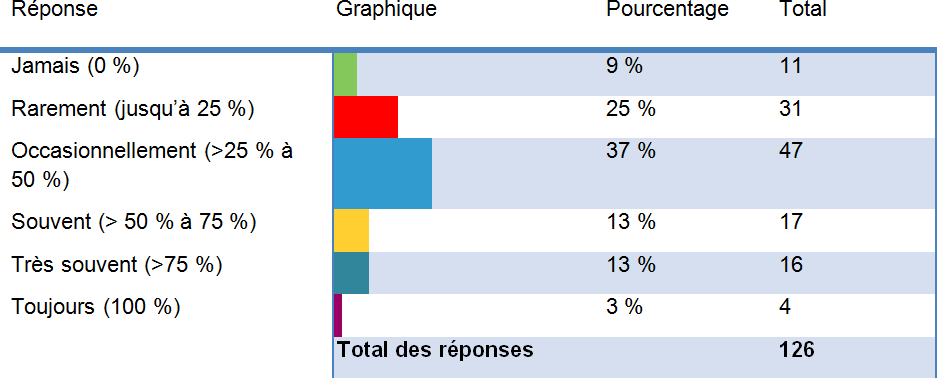

ii. Accès aux évaluations des autres évaluateurs

Une majorité des évaluateurs (89 %) ont consulté les évaluations soumises par les autres évaluateurs. D'après les commentaires transmis aux IRSC, cette fonctionnalité s'est révélée très utile. En moyenne, les évaluateurs ont passé deux heures ou moins à lire les autres évaluations. Toutefois, rien de concret ne permet à l'heure actuelle d'affirmer que de pouvoir lire les évaluations des autres a aidé les évaluateurs à en arriver à leur note définitive. Seulement 15 % des répondants ont indiqué que les autres évaluations les avaient aidés à en arriver à une note définitive souvent, très souvent ou toujours. Les IRSC examineront le manque de cohérence entre ces affirmations en analysant plus à fond les données du concours et les concours pilotes futurs, et ils affineront aussi les questions pertinentes dans les prochains sondages.

iii. Discussion en ligne asynchrone

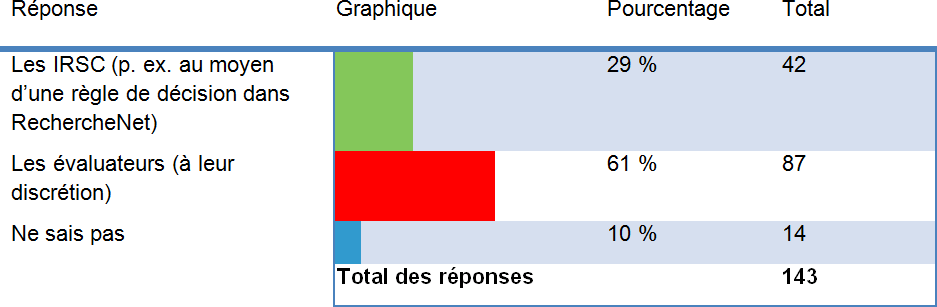

La discussion en ligne asynchrone a été utilisée par la majorité des évaluateurs (88 %). L'écart dans les notes a été le facteur le plus courant (87 %) utilisé pour déterminer si la demande devrait faire l'objet d'une discussion. Une minorité d'évaluateurs (29 %) ont mentionné que des instructions des IRSC pour décider s'il y a lieu de discuter d'une demande réduiraient leur charge de travail; toutefois, 61 % des évaluateurs estimaient que cette décision revenait aux évaluateurs. Les IRSC étudient actuellement les options pour l'animation des discussions afin de faciliter ce processus.

Conclusion et résumé des changements découlant du concours pilote

Les améliorations au processus d'évaluation à distance dans le concours pilote se sont traduits par de nombreux changements positifs dans le processus d'évaluation et serviront de point de départ aux projets futurs. En réponse à l'analyse des données, aux observations et aux commentaires des évaluateurs pour ce premier concours pilote, des améliorations ont été apportées à certains des processus et des fonctionnalités des prochains concours pilotes. Afin d'améliorer l'efficacité du nouveau processus de sélection, plusieurs autres fonctionnalités, énumérées ci après, ont été ajoutées à RechercheNet pour le concours pilote de subventions sur la synthèse des connaissances et la phase 2 du concours pilote sur les bourses de recherche :

- Les dates limites pour terminer les diverses tâches dans le processus de sélection sont maintenant affichées dans RechercheNet.

- Les mesures suivantes amélioreront la discussion en ligne asynchrone et son processus :

- Permettre aux évaluateurs d'avoir accès aux renseignements relatifs à la demande et à l'évaluation sans fermer l'outil de discussion;

- Un tableau montrera les cotes de chaque évaluateur en haut de l'écran de discussion;

- Limiter les alinéas dans la zone de texte pour empêcher le texte d'être réduit, peu importe le nombre de réponses;

- Lancer la période de discussion une fois que tous les évaluateurs chargés d'une demande particulière ont présenté leur évaluation préliminaire ou au plus tard à une date prédéterminée dans le système, selon la première de ces éventualités;

- Abréger le délai prévu pour la discussion;

- Accroître la responsabilisation dans le processus en révélant l'identité de tous les évaluateurs à la date limite pour rendre les évaluations préliminaires, que ces évaluations aient été rendues au non;

- Les évaluateurs qui n'ont pas présenté leur évaluation verront l'identité des autres évaluateurs de la demande, mais ne verront pas leurs évaluations.

- Permettre aux évaluateurs d'avoir accès aux renseignements relatifs à la demande et à l'évaluation sans fermer l'outil de discussion;

- Les mesures suivantes amélioreront l'interface de l'évaluateur dans RechercheNet :

- Afficher toutes les demandes confiées à un évaluateur sur une seule page;

- Donner la possibilité aux évaluateurs d'afficher plus de détails de la demande et de voir l'évaluation des autres évaluateurs;

- Afficher les cotes d'après leur valeur réelle et non leur valeur pondérée calculée;

- Créer un classement dynamique des demandes pour que leur rang change à mesure que des cotes sont entrées pour chaque critère de sélection.

- Les commentaires écrits seront rendus obligatoires dans la grille d'évaluation structurée.

Annexe 1 : Résultats détaillés du sondage

Taux de réponse

Le sondage a été envoyé à 209 évaluateurs et 145 réponses ont été reçues, pour un taux de réponse de 70 %.

Caractéristiques de l'évaluateur

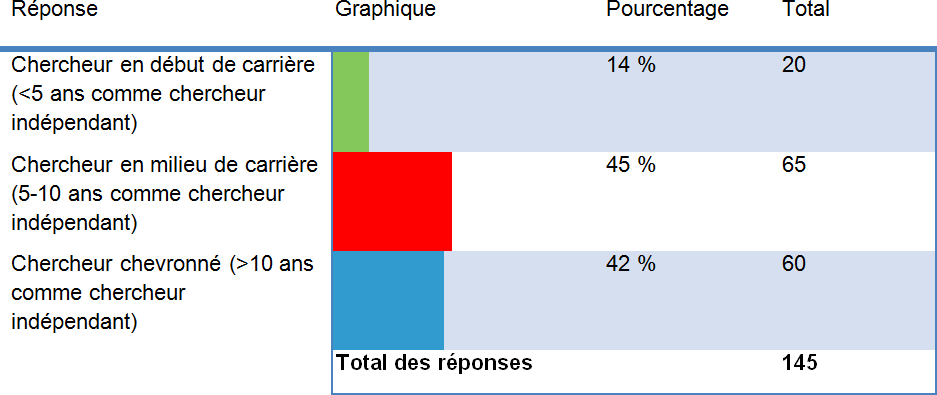

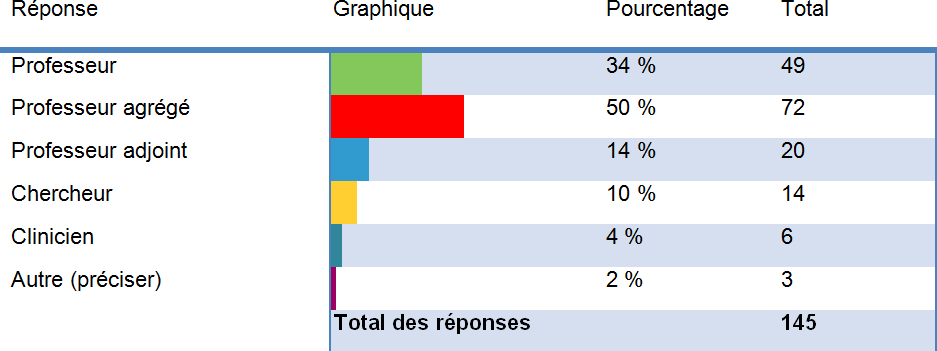

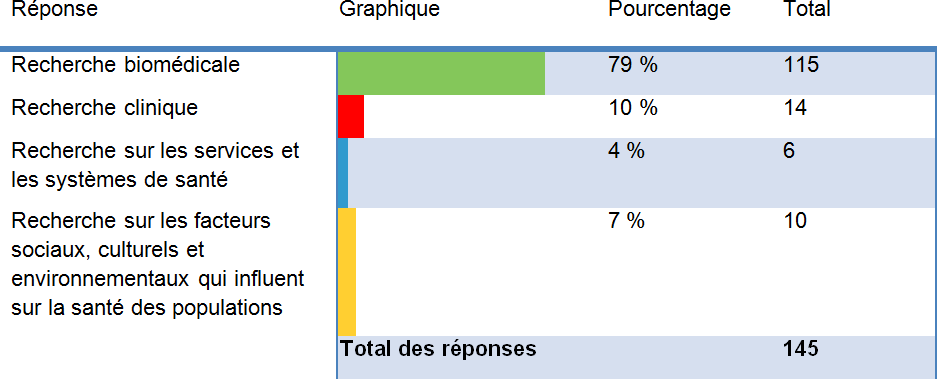

Les évaluateurs étaient des chercheurs en milieu de carrière (45 %) ou chevronnés (42 %), principalement du domaine de la recherche biomédicale (79 %). La moitié des répondants étaient professeurs agrégés (50 %), et 34 %, professeurs.

Remarque : la répartition (par thème) des évaluateurs dans ce concours est représentative de la répartition (par thème) des demandes.

Figure 1. Comment vous décririez-vous?

Description détaillée de la figure 1

Figure 2. Parmi les postes suivants en recherche, lesquels s'appliquent à votre situation?

Description détaillée de la figure 2

Figure 3. Quel est votre principal domaine de recherche?

Description détaillée de la figure 3

Accès aux évaluations des autres évaluateurs

En tout, 89 % des évaluateurs ont pris le temps de lire les évaluations des autres évaluateurs. La plupart (93 %) ont passé en tout deux heures ou moins à lire les évaluations des autres. Toutefois, rien de concret ne donne à penser que la lecture les évaluations des autres a aidé les évaluateurs à décider de leur note définitive. Voir figure 6.

Figure 4. Avez-vous regardé les autres évaluations des demandes qui vous ont été assignées?

Description détaillée de la figure 4

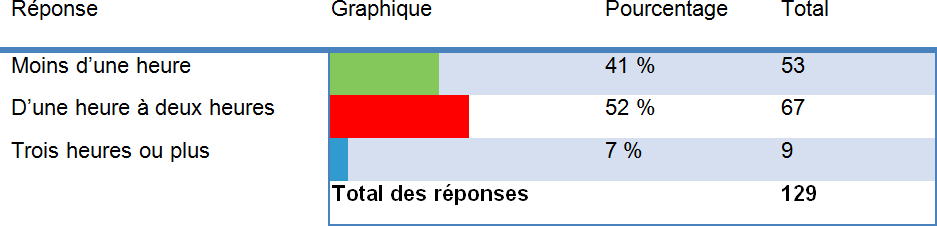

Figure 5. Combien de temps additionnel en tout (pour toutes les demandes) avez-vous consacré à la lecture des évaluations des autres évaluateurs?

Description détaillée de la figure 5

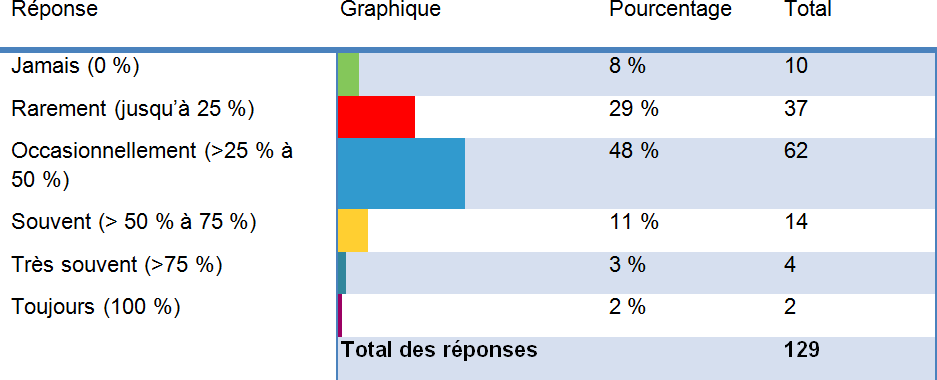

Figure 6. À quelle fréquence la lecture des autres évaluations vous a-t-elle aidé à finaliser la note que vous avez soumise?

Description détaillée de la figure 6

Discussion en ligne

La discussion en ligne asynchrone a été utilisée par 88 % des évaluateurs. L'écart dans les notes a été le facteur commun (87 %) pour déterminer si une discussion était nécessaire. Toutefois, les commentaires donnent à penser que les IRSC devraient fournir plus d'instructions pour indiquer quand il y aurait lieu de discuter d'une demande. Rien ne montre clairement si la discussion a aidé à modifier les notes définitives. Voir figure 12.

Commentaires représentatifs

- La demande a fait l'objet de discussions seulement si elle est près d'être finançable.

- Certaines demandes n'ont peut être pas besoin de faire l'objet de discussions (les notes sont semblables entre les évaluateurs).

- Les IRSC devraient lancer ou animer la discussion au besoin.

- Les évaluateurs NE devraient PAS pouvoir présenter une note définitive sans discussion.

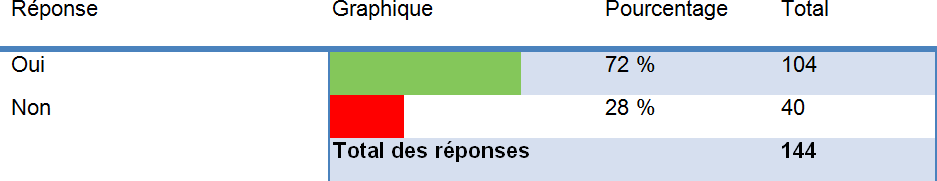

Figure 7. Avez-vous commencé une discussion en ligne?

Description détaillée de la figure 7

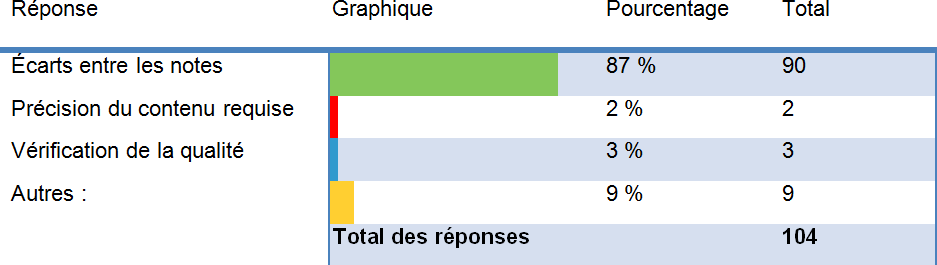

Figure 8. Quels facteurs avez-vous utilisés pour déterminer si une discussion en ligne était nécessaire pour une demande?

Description détaillée de la figure 8

Figure 9. Qui devrait décider quand une discussion en ligne doit avoir lieu?

Description détaillée de la figure 9

Figure 10. Avez-vous participé à une discussion en ligne?

Description détaillée de la figure 10

Figure 11. Est-ce qu'une discussion en ligne augmente la quantité de temps requise pour effectuer l'évaluation d'une demande (en moyenne) dans ce concours?

Description détaillée de la figure 11

Figure 12. À quelle fréquence la discussion en ligne vous a-t-elle aidé à finaliser la note que vous avez soumise?

Description détaillée de la figure 12

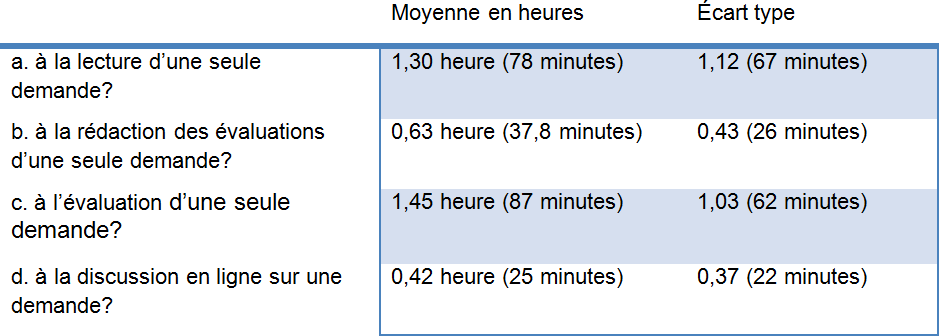

Évaluation des demandes

Quand ils évaluent une demande, les évaluateurs consacrent plus de temps à la lecture de cette demande (78 minutes) qu'à la rédaction de leur rapport (38 minutes). Contrairement aux programmes de subventions, le programme de bourses de recherche a une formule d'évaluation établie. La demande est beaucoup plus courte et les évaluateurs sont invités à la commenter brièvement pour chaque critère.

Figure 13. How much time, on average, did you spend on:

Description détaillée de la figure 13

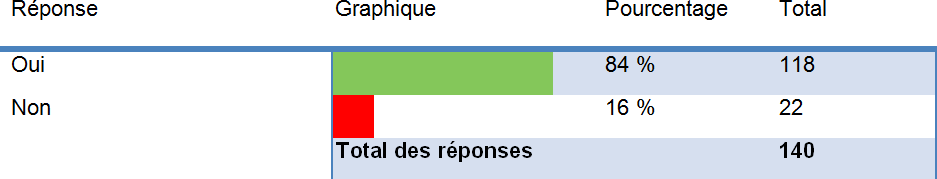

Processus d'évaluation par les pairs et technologie

La plupart des évaluateurs étaient d'avis que le processus d'évaluation par les pairs est efficient (84 %) et que la technologie est facile à utiliser (91 %). Néanmoins, de nombreuses recommandations pour améliorer le processus et la technologie ont été faites, et certaines seront adoptées dans les concours pilotes à venir. Voir la section Résumé des changements ci dessus.

Figure 14. Est-ce que le processus d'évaluation par les pairs était efficient?

Description détaillée de la figure 14

Commentaires représentatifs : Comment le processus d'évaluation des pairs pourrait-il être amélioré?

- Impossibilité de voir les notes, les commentaires et les données relatives à la demande au cours de la discussion en ligne; nécessité de naviguer entre les écrans;

- Offrir des options pour une forme quelconque de communication verbale;

- Encourager les évaluateurs à présenter leurs évaluations à temps – ou prévoir des conséquences si le processus n'est pas respecté;

- Uniformiser le modèle de l'évaluation – diviser les commentaires en catégories : propositions, publications, etc.

- Le CV commun contient trop de renseignements non pertinents. La présentation est affreuse. Certaines colonnes sont trop étroites, ce qui rend la lecture difficile;

- Le processus d'évaluation à distance est correct pour les bourses d'études et les bourses de recherche au niveau des stagiaires, mais NE saurait PAS remplacer l'interaction en personne qui est nécessaire pour les demandes de subventions;

- Les évaluateurs devraient être évalués;

- Une demande plus courte.

Figure 15. Est-ce que la technologie employée pour effectuer les évaluations était conviviale?

Description détaillée de la figure 15

Commentaires représentatifs : Comment la technologie utilisée pour les évaluations pourrait elle être améliorée?

- Capacité de voir les commentaires/notes pendant la discussion en ligne;

- Le CV commun contient des renseignements en double qui apparaissent dans différentes sections, sous différentes formes. La présentation de l'information complique les choses;

- Les notes devraient être mises à jour à mesure qu'elles sont révisées pour que les autres évaluateurs les voient;

- Ajoutez la vidéoconférence ou offrez des options pour établir une autre forme de communication;

- La discussion asynchrone n'est ni inefficace ni fiable;

- Désignez un animateur pour la discussion.

Annexe 2 : Sondage à l'intention des évaluateurs pour les bourses de recherche

- Comment vous décririez-vous?

- Chercheur en début de carrière (<5 ans comme chercheur indépendant)

- Chercheur en milieu de carrière (5-10 ans comme chercheur indépendant)

- Chercheur chevronné (>10 ans comme chercheur indépendant)

- Parmi les postes suivants en recherche, lesquels s'appliquent à votre situation?

Veuillez choisir toutes les réponses qui s'appliquent :- Professeur

- Professeur agrégé

- Professeur adjoint

- Chercheur

- Clinicien

- Autre (veuillez préciser) :

- Quel est votre principal domaine de recherche (thème)?

- Recherche biomédicale

- Recherche clinique

- Recherche sur les services et les systèmes de santé

- Recherche sur les facteurs sociaux, culturels et environnementaux qui influent sur la santé des populations

- a) Avez-vous regardé les autres évaluations des demandes qui vous ont été assignées?

- Oui

- Non

- b) Combien de temps additionnel en tout (pour toutes les demandes) avez-vous consacré à la lecture des évaluations des autres évaluateurs?

- Moins d'une heure

- D'une heure à deux heures

- Trois heures ou plus

- c) À quelle fréquence la lecture des autres évaluations vous a-t-elle aidé à finaliser la note que vous avez soumise?

- Jamais (0 %)

- Rarement (jusqu'à 25 %)

- Occasionnellement (>25 % à 50 %)

- Souvent (> 50 % à 75 %)

- Très souvent (>75 %)

- Toujours (100 %)

- a) Avez-vous commencé une discussion en ligne?

- Oui

- Non

- b) Quels facteurs avez-vous utilisés pour déterminer si une discussion en ligne était nécessaire pour une demande?

(Choisissez toutes les catégories pertinentes)- Écarts entre les notes

- Précision du contenu requise

- Vérification de la qualité

- Autres :

- a) Qui devrait décider quand une discussion en ligne doit avoir lieu?

- Les IRSC (p. ex. au moyen d'une règle de décision dans RechercheNet)

- Les évaluateurs (à leur discrétion)

- Ne sais pas

- b) Quels critères explicites devrait-on utiliser pour déterminer si une discussion en ligne doit avoir lieu?

- a) Avez-vous participé à une discussion en ligne?

- Oui

- Non

- b) Est-ce qu'une discussion en ligne augmente la quantité de temps requise pour effectuer l'évaluation d'une demande (en moyenne) dans ce concours?

- Moins d'une heure

- D'une heure à deux heures

- Trois heures ou plus

- c) À quelle fréquence la discussion en ligne vous a-t-elle aidé à finaliser la note que vous avez soumise?

- Jamais (0 %)

- Rarement (jusqu'à 25 %)

- Occasionnellement (>25 % à 50 %)

- Souvent (> 50 % à 75 %)

- Très souvent (>75 %)

- Toujours (100 %)

- Combien de temps, en moyenne, avez-vous consacré (arrondir au quart d'heure près)

(Indiquez « 0 » si la colonne est sans objet)

Heures | minutes- à la lecture d'une seule demande?

- à la rédaction des évaluations d'une seule demande?

- à l'évaluation d'une seule demande?

- à une discussion en ligne sur une demande?

- a) Est-ce que le processus d'évaluation par les pairs était efficient?

- Oui

- Non

- b) How can it be improved?

- a) Est-ce que la technologie employée pour effectuer les évaluations était conviviale?

- Oui

- Non

- b) Comment peut-il être amélioré?

- a) Avez-vous suivi la formation en ligne pour ce concours pilote de bourses?

- Oui

- Non

- b) Comment peut-elle être amélioré?

- Avez-vous autre chose à ajouter?

- Date de modification :