Guide d'évaluation dans le domaine de la recherche en santé

Préparé par : Sarah Bowen, Ph.D.

Professeure agrégée

Département des sciences de la santé publique, École de santé publique

Université de l'Alberta

sbowen@ualberta.ca

Table des matières

- Introduction

- Section 1 : L'évaluation : un aperçu

- Section 2 : Pour commencer

- Étape 1 : Déterminer les buts de l'évaluation

- Étape 2 : Identifier les utilisateurs prévus de l'évaluation

- Étape 3 : Créer une structure et un mécanisme de collaboration

- Étape 4 : Évaluer les capacités d'évaluation, former une équipe d'évaluation

- Étape 5 : Recueillir les données pertinentes

- Étape 6 : Bâtir un consensus autour de l'évaluation

- Étape 7 : Décrire le programme / l'intervention

- Résumé

- Section 3 : Concevoir une évaluation

- Matrice de planification d'une évaluation

- Étape 8 : Confirmer le but, établir l'objet de l'évaluation

- Étape 9 : Établir et prioriser les questions d'évaluation

- Étape 10 : Choisir les méthodes et les sources de données

- Étape 11 : Préciser les ressources et les secteurs de responsabilité

- Étape 12 : Exécuter les activités d'évaluation

- Étape 13 : Communiquer les conclusions de l'évaluation

- Section 4 : Questions propres à l'évaluation

- Conclusion

- Références

- Section 5 : Ressources

Introduction

Il a été déterminé qu'un module d'apprentissage sur l'évaluation répondait à un besoin prioritaire des chercheurs et des pairs évaluateurs. Pour faire face à la multitude de défis posés au système de santé, les chercheurs et les gestionnaires du système de santé proposent des changements importants aux pratiques cliniques, aux méthodes de gestion et aux approches de santé publique actuelles. Cela oblige à soumettre rapidement les programmes actuels et les innovations à une évaluation rigoureuse. L'évaluation est une stratégie utile pour produire des connaissances immédiatement applicables à un contexte particulier et, avec l'emploi de certaines méthodes d'évaluation, des connaissances transférables à l'ensemble du système.

Outre le fait que les propositions de recherche doivent souvent comporter un volet « évaluation », des bailleurs de fonds offrent des possibilités de financement axées sur la mise à l'essai de certaines innovations et la mise en pratique des résultats. La nature même de ces propositions oblige à y joindre des plans d'évaluation solides et bien conçus pour assurer l'utilité de l'information produite. Pourtant, les connaissances et les compétences en évaluation de nombreux chercheurs (et gestionnaires du système de santé) sont limitées.

But et objectifs du module

Le présent module d'apprentissage a donc pour but de développer les connaissances et les compétences nécessaires à l'évaluation des initiatives dans le domaine de la santé et de la recherche en santé (y compris des initiatives d'application des connaissances).

Les objectifs du module sont :

- Conscientiser les chercheurs et les évaluateurs sur le potentiel de l'évaluation pour appuyer l'action éclairée par des données probantes;

- Soutenir l'élaboration de plans d'évaluation conformes aux exigences et/ou adaptés aux propositions de recherche;

- Aider les pairs évaluateurs et les évaluateurs du mérite à porter un jugement sur les plans d'évaluation.

Portée et limites du module

Le présent module d'apprentissage :

- fournit un aperçu de l'étendue et du potentiel des activités d'évaluation;

- définit des concepts clés, en plus de démentir des idées fausses concernant l'évaluation;

- explore la relation entre l'évaluation et l'application des connaissances;

- aide à déterminer le but, la méthode et l'objet d'une évaluation;

- cerne les principales étapes du processus de planification et d'exécution d'une évaluation, et donne des conseils à ce sujet.

Tandis qu'il fournira un bref aperçu des principaux concepts dans le domaine de l'évaluation et qu'il se fonde sur diverses méthodes (théories) d'évaluation, le module se veut avant tout un guide pratique pour les personnes compétentes en recherche, mais pourvues d'une expérience limitée en évaluation. Il est important de se rappeler que même si le module se concentre sur l'évaluation dans le contexte de la recherche et de l'application des connaissances en santé, il existe de multiples approches, théories et méthodes adaptées à différents contextes.

Comme on reconnaît de plus en plus les avantages d'inclure les utilisateurs des connaissances1 comme partenaires dans de nombreuses activités d'évaluation, le module comprend aussi des conseils destinés aux personnes qui collaborent à des activités d'évaluation avec des intervenants du système de santé ou d'autres partenaires.

Le module ne tente pas de couvrir tous les aspects importants de la conception d'une évaluation (p. ex. comment minimiser et contrôler les biais, établir un budget ou mettre en œuvre le plan d'évaluation), car il s'adresse aux chercheurs, et l'on présume que ceux-ci sont outillés pour gérer ces aspects. De plus, bien que le module présente les étapes de la conception d'un plan d'évaluation, il ne fournit pas de « modèle » applicable uniformément à toute évaluation. Il guide plutôt le lecteur dans le processus d'élaboration d'un plan d'évaluation, étant donné que la conception d'une évaluation nécessite l'adaptation des principes d'évaluation aux questions d'évaluation rattachées à un contexte particulier.

Structure du module

Le module se divise en cinq sections. La section 1, L'évaluation : un aperçu, présente un survol de la fonction d'évaluation, dément certaines idées fausses et définit les termes clés qui seront utilisés dans le module. La section 2, Pour commencer, oriente le travail préparatoire nécessaire à la planification d'une évaluation, et la section 3, Concevoir une évaluation, guide le lecteur dans l'élaboration d'un plan d'évaluation étape par étape.

La section 4, Questions propres à l'évaluation, aborde certaines difficultés d'ordre éthique, conceptuel et logistique particulières à l'évaluation. La dernière section du module, la section 5, Ressources, comprend un glossaire, un aide-mémoire pour l'évaluation et des modèles d'évaluation.

Dans tout le module, les concepts sont illustrés par des exemples concrets tirés d'études de cas réelles en évaluation, mais adaptés aux fins du module par souci de confidentialité. Un résumé de ces cas figure à la page suivante.

Études de cas utilisées dans le module

Étude de cas no 1 : Patients orphelins

Un ministère de la Santé provincial fait évaluer à forfait trois différents modèles de soins pour les patients hospitalisés qui sont sans médecin de famille (patients orphelins) afin qu'ils soient suivis durant leur séjour à l'hôpital. En plus de s'intéresser à ce qui « fonctionne le mieux » pour les patients, la province veut obtenir une évaluation économique, étant donné que chaque modèle possède sa propre structure de coûts et que le total des coûts est incertain.

Étude de cas no 2 : Aide à la décision automatisée

On a décidé de mettre à l'essai un logiciel commercial de commande de tests, qui combine une fonction de commande automatisée et une fonction d'aide à la décision sur les tests à commander destinée aux médecins. Le module d'aide à la décision est fondé sur les lignes directrices adoptées par une association médicale nationale sur la base de données probantes. Les bailleurs de fonds exigent une évaluation du logiciel pilote, étant donné que l'intention est d'en étendre l'usage à toute la région et à d'autres provinces si les résultats de l'évaluation le justifient.

Section 1 : L'évaluation : un aperçu

Le domaine de l'évaluation, dans sa forme actuelle, a évolué à partir d'une variété de racines, d'objectifs généraux et de disciplines et couvre de nombreuses « approches » (théories et modèles) différentes. Divers auteurs définissent l'évaluation et classent les types d'évaluation différemment, insistent sur divers aspects théoriques et pratiques de l'évaluation et utilisent les termes de façon très variable (en raison des cadres théoriques différents).

La présente section couvrira diverses approches d'évaluation et soulignera certaines de leurs différences. Cependant, le module se veut avant tout un guide pratique à l'usage des personnes qui, en dépit de leur expérience en recherche, ont été peu exposées au travail d'évaluation. On peut trouver dans Internet une multitude de guides et de ressources en évaluation publiés par des organismes, des associations et des personnes travaillant en évaluation. L'utilité et la qualité de ces ressources et les approches qu'elles utilisent varient considérablement (Robert Wood Johnson Foundation, 2004). Même s'il existe d'excellentes ressources (dont beaucoup offrent l'avantage de structurer l'évaluation pour un secteur ou une question en particulier), beaucoup trop de guides proposent des approches d'évaluation formalistes : un modèle à suivre par le novice.

Ce n'est pas l'approche suivie ici. Plutôt que d'offrir un modèle applicable à n'importe quelle initiative, ce module vise à fournir aux chercheurs de formation les connaissances de base nécessaires pour comprendre les concepts et les choix en matière d'évaluation, et pour les adapter à une activité d'évaluation particulière.

Similitudes et différences entre la recherche et l'évaluation

Les similitudes et les différences entre la recherche et l'évaluation font depuis longtemps l'objet d'un intense débat : les perspectives sont diverses et souvent divergentes (Levin-Rozalis, 2003). Certains font valoir que l'évaluation et la recherche sont nettement différentes. Les défenseurs de cette position citent des facteurs comme la centralité de la dimension « appréciative » dans l'évaluation; le caractère intrinsèquement politique des activités d'évaluation; l'applicabilité limitée des conclusions des évaluations (résultats applicables localement ou à des fins précises, plutôt que transférables ou généralisables); et le rôle important de la théorie dans la recherche comparativement à son rôle dans l'évaluation. On fait valoir aussi souvent que le cadre stratégique et le contexte des évaluations obligent les évaluateurs à posséder des compétences uniques. Certains décrivent l'évaluation comme une profession, contrairement à la recherche, où les chercheurs appartiennent à différentes disciplines.

Cette différence apparente est renforcée par le fait que les évaluateurs et les chercheurs habitent souvent des mondes très différents. Les chercheurs sont concentrés en milieu universitaire et sont souvent engagés dans des activités décrites comme « motivées par la curiosité ». Beaucoup ne sont pas exposés au travail d'évaluation durant leur formation. Les évaluateurs (dont beaucoup ne sont pas formés au doctorat) sont plus susceptibles d'œuvrer dans le système de santé ou d'être établis comme consultants. Dans la plupart des cas, les deux appartiennent à des organismes professionnels séparés, participent à des conférences différentes et obéissent à des règles d'éthique distinctes (avec des points communs).

En revanche, certains voient l'évaluation comme une forme de recherche, qui utilise des méthodes (et des normes) scientifiques pour répondre à des questions pratiques dans un délai rapide. Ils font valoir que les différences couramment citées entre l'évaluation et la recherche ne s'appliquent pas à toutes les formes de recherche, mais seulement à certaines. On remarque que les formes de recherche plus engagées comportent les mêmes caractéristiques et obéissent aux mêmes exigences que l'évaluation, en plus de nécessiter des compétences similaires : compétences en communication et en collaboration, sensibilité aux dimensions politiques, réceptivité au contexte et capacité de produire des conclusions utiles en temps rapide. On fait aussi remarquer que l'évaluation n'est pas seule à puiser pragmatiquement dans diverses perspectives, disciplines et méthodes, et que de nombreux chercheurs le font aussi. Beaucoup d'évaluateurs insistent sur la dimension « production de connaissances » de l'évaluation (Preskill, 2008), et l'évaluation à base théorique suscite de plus en plus d'intérêt (Coryn et al, 2010). Cet intérêt découle des critiques de plus en plus nombreuses à l'égard de l'évaluation de type « boîte noire » (qui se contente de mesurer les effets des interventions sans trop se préoccuper de la façon dont les effets ont été obtenus). Les conclusions des évaluations à base théorique pourraient s'appliquer à d'autres contextes (c.-à-d. être transférables). On fait valoir aussi que toutes les formes d'évaluation ne sont pas axées sur la détermination de la valeur ou de l'utilité; l'évaluation peut avoir d'autres buts. De nombreux auteurs notent l'utilité de « l'esprit d'évaluation » dans la planification et la conduite des activités de recherche.

Importance pour les chercheurs de comprendre comment évaluer

Les chercheurs devraient posséder des connaissances en évaluation pour un certain nombre de raisons :

Besoins du système de santé

La première raison est l'urgence des problèmes du système de santé, qui incite à mettre à l'essai de nombreuses innovations et à remettre en question des processus et des programmes établis.

Les discussions avec les gestionnaires et les cadres du système de santé font ressortir le fait que bon nombre de questions de « recherche » auxquelles ils veulent des réponses sont, en réalité, des questions d'évaluation. Ils veulent savoir si une stratégie particulière fonctionne, ou fonctionnera, pour remédier à un problème connu. Ils désirent obtenir de l'information précise et crédible en temps opportun pour éclairer les décisions dans le contexte de leur travail. Par conséquent, on reconnaît de plus en plus la nécessité de l'expertise en évaluation pour guider les décisions. L'évaluation peut répondre à ces besoins, et l'étude d'évaluation, réalisée par des chercheurs en évaluation compétents, peut assurer la rigueur des activités d'évaluation et optimiser l'applicabilité des conclusions à différents contextes.

Des compétences en recherche sont nécessaires pour s'assurer que ces évaluations (qui éclairent les décisions non seulement sur la poursuite ou la diffusion d'une innovation, mais aussi sur le retrait de services existants ou la modification de processus établis) sont bien conçues, exécutées et interprétées. Les plans d'évaluation mal conçus et simplistes peuvent engendrer de mauvaises décisions – une situation qui peut être coûteuse pour tous les Canadiens.

Attentes des bailleurs de fonds de la recherche

De nombreuses propositions de recherche comportent une certaine forme d'évaluation. Par exemple, un nombre grandissant de possibilités de financement amènent des chercheurs à proposer des projets « pilotes » visant la mise à l'essai de nouvelles stratégies. Pour ces propositions, un plan d'évaluation rigoureux est une composante essentielle discutée par le comité d'évaluation. Les résultats de cette discussion ont de fortes chances d'influencer le classement des propositions.

L'évaluation comme stratégie d'application des connaissances

Les chercheurs intéressés par les aspects pratiques et théoriques de l'application des connaissances profiteront aussi du développement de leurs compétences en évaluation. L'évaluation (en particulier l'évaluation concertée) peut promouvoir l'utilisation appropriée des connaissances. Les décideurs font souvent état de deux frustrations : a) manque fréquent d'articles de recherche utiles pour affronter les défis qui se présentent à eux et b) besoin d'intégrer les connaissances contextuelles à la recherche pour éclairer les décisions locales. De leur côté, les chercheurs déplorent souvent l'ignorance des concepts et des méthodes de recherche affichée par les décideurs.

Les études d'évaluation bien conçues et pourvues en ressources débutent par une revue critique et une synthèse de la littérature et des données locales et contextuelles. Cela peut renseigner les évaluateurs et l'équipe du programme sur l'état des connaissances sur la question et sur les pratiques actuelles prédominantes. Le processus de conception d'un plan d'évaluation, d'orientation de l'évaluation, d'interprétation des données et de prise de décision à partir des données en cours d'évaluation peut promouvoir l'utilisation des données dans tout le cycle de planification/exécution/évaluation. Et surtout, une approche d'évaluation concertée qui engage les intervenants clés de façon significative peut contribuer à développer l'esprit d'évaluation, une culture qui valorise les compétences en évaluation et en recherche à l'échelle des programmes/organisations. Ces compétences peuvent ensuite servir à d'autres activités organisationnelles. Une évaluation peut être conçue de sorte à produire des données initiales pouvant éclairer le processus décisionnel en cours. Et enfin, étant donné qu'une évaluation conçue de manière concertée reflète les questions d'intérêt pour les décideurs, l'évaluation peut augmenter la probabilité que les décideurs se fient et donnent suite aux données d'évaluation.

Définition de l'évaluation

On constate que « l'évaluation – plus que toute autre science – se définit par la description qu'en font les gens, et les gens la décrivent actuellement de toutes sortes de façons » (Glass, 1980). Le présent module est basé sur la définition suivante, adaptée d'une définition communément utilisée du concept (Patton 1997, page 23) :

La collecte systématique d'information sur les activités, les caractéristiques et les résultats de programmes, de services, de politiques ou de processus, dans le but de porter un jugement sur les programmes/processus, d'améliorer l'efficacité et/ou d'éclairer les décisions sur la voie à suivre.

Cette définition, comme beaucoup d'autres, fait ressortir le côté systématique des activités d'évaluation de qualité. Par exemple, selon Rossi et al., l'évaluation se définit comme « ... l'emploi des méthodes de recherche sociale pour l'étude systématique de l'efficacité de programmes d'intervention sociale ». (2004, p. 28). Elle met aussi en lumière d'autres points qui sont souvent source de malentendus et d'idées fausses concernant l'évaluation.

Idées fausses concernant l'évaluation

L'évaluation fait communément l'objet d'idées fausses qui contribuent à en limiter l'utilisation par les chercheurs du secteur de la santé.

Évaluation = évaluation de programme

Comme l'illustre la définition ci-dessus, l'évaluation peut viser non seulement des programmes, mais aussi des politiques, des produits, des processus ou le fonctionnement d'organisations entières. De plus, l'utilité des résultats des évaluations ne se limite pas aux programmes évalués. Tandis que les évaluations de programmes servent à éclairer les décisions quant à la gestion des programmes, les études d'évaluation peuvent générer des connaissances applicables à d'autres contextes.

L'évaluation sert à déterminer la valeur ou l'utilité d'un programme

L'évaluation repose sur le concept « d'appréciation ». En fait, certains auteurs définissent l'évaluation exactement dans ces termes. Scriven, par exemple, définit l'évaluation comme « le processus de détermination du mérite, de l'utilité ou de la valeur de quelque chose, ou le produit de ce processus » (1991; p. 139).La collecte de données simplement descriptives ne constitue pas une évaluation (p. ex. « Combien de personnes ont participé au programme X? » n'est pas une question d'évaluation, mais cette information peut être utile pour répondre à une telle question). Cependant, les évaluations peuvent avoir des buts autres que porter un jugement sur la valeur ou l'utilité d'un programme ou d'une activité (évaluation sommative). L'évaluation peut également servir à parfaire ou à améliorer un programme (évaluation formative) ou à guider la conception et l'élaboration d'un programme ou d'une structure organisationnelle (évaluation de développement). L'évaluation peut aussi servir spécifiquement à créer de nouvelles connaissances sur des sujets où les connaissances sont limitées. La détermination adéquate du but d'une évaluation est couverte plus en détail à la section 2, étape 1.

L'évaluation a lieu à la fin d'une initiative

Cette idée fausse découle de la précédente : si l'évaluation ne consiste qu'à juger du mérite d'une initiative, il est alors logique que ce jugement survienne une fois que le programme est bien établi. Le commentaire « trop tôt pour évaluer », souvent entendu, reflète cette idée, qui fait en sorte que l'évaluation – si évaluation il y a – survient à la fin du programme. Malheureusement, cela signifie souvent le gaspillage de nombreuses occasions d'utiliser l'évaluation pour guider l'élaboration d'un programme (prévoir et prévenir les problèmes et faire des correctifs en cours de route) et s'assurer de recueillir des données suffisantes en appui à l'évaluation de fin de projet. Cela contribue aussi à promouvoir l'idée fausse que l'évaluation ne s'intéresse qu'aux résultats.

L'évaluation ne s'intéresse qu'aux résultats

Depuis quelques années, l'évaluation tend à être davantage axée sur les résultats que sur les processus. Cela est une bonne chose, car on mesure trop souvent ce qui est facilement mesurable (p. ex. services fournis aux patients) au détriment de ce qui est important de mesurer (p. ex. effets de ces services sur la santé). Cet accent mis sur l'évaluation des résultats peut, cependant, faire négliger d'autres formes d'évaluation et même entraîner la mesure prématurée des résultats. Il est important de déterminer si et quand il est approprié de mesurer les résultats de l'activité évaluée. En mesurant les résultats trop tôt, on risque de gaspiller des ressources et d'obtenir de l'information erronée.

Comme on le verra dans le présent module, une évaluation peut générer une grande quantité d'information utile, même lorsqu'il n'est pas encore approprié ou possible de mesurer les résultats. De plus, même lorsqu'une initiative est assez bien établie pour qu'on puisse en mesurer les résultats, le fait de se concentrer uniquement sur les résultats peut faire négliger des aspects clés pour les responsables des politiques/gestionnaires de programme (Bonar Blalock, 1999). Parfois, il est aussi (ou plus) important de comprendre les facteurs qui ont contribué aux résultats observés.

Il existe deux types d'évaluation : la sommative et la formative

Pour certains auteurs (et guides d'évaluation), il existe seulement deux motifs et deux types d'évaluation : l'évaluation sommative et l'évaluation formative. La première désigne un jugement sur la valeur ou l'utilité d'un programme au terme de celui-ci, et se concentre habituellement sur les résultats. En revanche, l'évaluation formative vise à améliorer une initiative et se déroule normalement à l'étape de son élaboration ou de son exécution. Il existe une citation célèbre de Robert Stake à ce sujet : « Lorsque le cuisinier goûte la soupe, c'est formatif; lorsque les invités la goûtent, c'est sommatif ». Cependant, comme nous le verrons dans les prochaines sections du module, l'évaluation est un champ d'activité plus nuancé et plus riche en potentiel que ne le laisse supposer cette simple dichotomie. La section 2, étape1, et la section 3, étape 8, renseignent sur les choix possibles en matière d'évaluation.

Évaluation = mesure du rendement

Une idée fausse assez répandue parmi les décideurs en matière de santé est qu'évaluation est synonyme de mesure du rendement. La mesure du rendement est principalement un outil de planification et de gestion, tandis que l'étude d'évaluation est un outil de recherche (Bonar Blalock, 1999). La mesure du rendement se concentre sur les résultats, la plupart du temps évalués par quelques indicateurs quantitatifs. Cette dépendance à l'égard de la mesure des résultats et des plans d'évaluation de type « avant/après » pose un certain nombre de risques, y compris celui d'attribuer tout changement observé à l'intervention étudiée sans tenir compte d'autres influences, et celui de ne pas étudier des aspects importants non révélés par les données quantitatives. De plus, cela contribue à promouvoir l'idée fausse que l'évaluation doit se fonder uniquement sur des données quantitatives.

Tendant à se baser sur quelques mesures quantitatives de résultats bruts transmises par des systèmes d'information de gestion, les systèmes de gestion du rendement tardent à reconnaître et à résoudre les problèmes de validité, de fiabilité, de comparabilité, de diversité et d'analyse des données, qui peuvent influencer l'évaluation des programmes. Les systèmes de gestion du rendement ne cherchent habituellement pas à isoler l'impact net d'un programme – c'est-à-dire à faire la distinction entre les résultats attribuables au programme et à d'autres influences. C'est pourquoi on ne peut tirer de conclusion fiable sur la nature du lien entre les interventions et les résultats d'un programme, ni sur les effets relatifs de la variation d'éléments structurels du programme, sur la base de la mesure du rendement seulement (Bonar Blalock, 1999).

Il est important de demeurer conscient de ces idées fausses au moment d'entamer l'élaboration d'un plan d'évaluation; non seulement pour éviter soi-même de tomber dans le piège, mais aussi pour se préparer à communiquer avec les collègues et les personnes concernées par l'évaluation, dont beaucoup peuvent aborder l'activité d'évaluation avec de tels postulats.

Approches d'évaluation

On peut décrire l'évaluation comme un édifice reposant sur deux piliers : a) reddition de comptes et contrôle et b) recherche sociale systématique (Alkin & Christie, 2004). Les gouvernements (et d'autres bailleurs de fonds) insistent souvent, à raison, sur la fonction de reddition de comptes de l'évaluation, ce qui explique en partie la confusion entre mesure du rendement et évaluation. Puisque la prédominance de l'aspect reddition de comptes se traduit généralement par le recours à des approches de mesure du rendement, on néglige souvent d'étudier les raisons expliquant les résultats obtenus ou de recueillir des données à ce sujet (Bonar Blalock, 1999).

Il existe des dizaines, voire des centaines, d'approches d'évaluation différentes (que certains décriraient comme des « philosophies » et d'autres, comme des « théories »). Alkins et Christie (2004) représentent la théorie de l'évaluation sous la forme d'un arbre à trois branches principales : a) méthodes; b) appréciation; et c) utilisation. Certains auteurs donnent des exemples de ces trois branches : Rossi (méthodes) (Rossi et al, 2004), Scriven (appréciation) (Scriven, 1991) et Patton (utilisation) (Patton, 1997). Bien que certains auteurs (et praticiens) puissent s'aligner étroitement sur une de ces traditions, il ne s'agit pas de catégories fixes – avec le temps, de nombreux théoriciens de l'évaluation ont intégré des approches et des concepts initialement proposés par d'autres, et les praticiens optent souvent pour une approche pragmatique dans la conception de projets d'évaluation.

Chacune de ces « branches » regroupe de nombreuses approches d'évaluation particulières. Le présent module n'a pas pour objectif de toutes les passer en revue, mais il présente ci-dessous certains exemples.

Méthodes

Le volet « méthodes » a été initialement dominé par les praticiens des méthodes quantitatives. Cela a évolué au fil du temps, et on accorde aujourd'hui une plus grande valeur à l'intégration des méthodes d'évaluation qualitatives dans la branche des méthodes de « l'arbre » conceptuel.

La branche des méthodes, où prédominent la rigueur, la planification de la recherche et la théorie, est celle qui traditionnellement se rapproche le plus de la recherche. D'ailleurs, certains des fondateurs reconnus de la branche des méthodes sont aussi reconnus pour leur travail comme chercheurs. L'article fondamental intitulé Experimental and Quasi-experimental Designs for Research (Campbell and Stanley, 1966) a guidé tant le secteur de la recherche que celui de l'évaluation. Les théoriciens de cette branche insistent sur l'importance de prévenir les biais et d'assurer la validité des résultats.

L'évaluation à base théorique intéresse particulièrement les évaluateurs-chercheurs (Chen & Rossi, 1984). L'évaluation à base théorique favorise et soutient l'exploration théorique des programmes – et des mécanismes sous-jacents à tout changement observé. Cela contribue à promouvoir la conception et la mise à l'essai de théories et la transférabilité des nouvelles connaissances à d'autres contextes.

Appréciation

Certains théoriciens de cette branche croient que ce qui distingue les évaluateurs des autres chercheurs est que les premiers doivent donner une appréciation de leurs résultats – faire un jugement de valeur (Shadish et al., 1991). Beaucoup considèrent Michael Scriven comme le pilier de cette branche : selon sa vision, l'évaluation relève de la « science de l'appréciation » (Alkins & Christie, 2004). Scriven croit que la plus grande erreur que puisse commettre un évaluateur consiste à seulement transmettre de l'information, sans porter de jugement (Scriven, 1983). D'autres théoriciens (p. ex. Lincoln et Guba) soulignent l'importance de l'appréciation, sans toutefois en attribuer la responsabilité à l'évaluateur; selon eux, le rôle de celui-ci est de faciliter la négociation entre les intervenants clés dans la détermination de la valeur (Guba & Lincoln, 1989).

Contrairement aux promoteurs de l'évaluation à base théorique, les tenants de la branche de l'appréciation peuvent sous-estimer l'importance de comprendre pourquoi un programme fonctionne, puisque cela n'est pas toujours vu comme nécessaire à la détermination de sa valeur.

La centralité de la dimension appréciative dans l'évaluation peut poser des défis aux chercheurs de nombreuses disciplines, qui souvent évitent volontairement de faire des recommandations; rappellent prudemment aux utilisateurs la nécessité de pousser les recherches; et croient que « les données devraient parler d'elles-mêmes ». Cependant, avec l'augmentation de la demande en recherche utile aux politiques et aux pratiques, beaucoup de chercheurs s'interrogent sur leur rôle dans la prestation de conseils sur la pertinence et l'utilisation de leurs conclusions.

Utilisation

Un certain nombre d'approches d'évaluation (voir par exemple Patton, Stufflebeam, Cousins, Pawley, plus les autres) sont axées sur « l'utilisation ». Cette branche a vu le jour avec ce qu'on désigne souvent comme des théories axées sur les décisions (Alkin & Christie, 2004), conçues spécialement pour aider les intervenants dans la prise de décisions relatives aux programmes. Cette branche est notamment représentée par les travaux de Michael Q. Patton (auteur de Utilization-focused evaluation (1997)). Beaucoup d'approches d'évaluation concertée intègrent les principes de l'évaluation axée sur l'utilisation.

Le point de départ des approches axées sur l'utilisation est la conscience du fait que bon nombre de rapports d'évaluation, tout comme de recherche, finissent au fond d'un tiroir sans qu'on leur donne suite – même lorsque l'évaluation a été commandée par un ou plusieurs intervenants. Compte tenu de ce fait, les approches qui privilégient l'utilisation intègrent des stratégies pour promouvoir la prise de mesures appropriées en réponse aux conclusions. Elles insistent sur l'importance d'établir une collaboration véritable avec les intervenants dès le départ et d'intégrer des stratégies pour promouvoir l'acceptation et l'utilisation des conclusions de l'évaluation.

Les auteurs plus proches de la branche de l'utilisation constatent qu'ils ont beaucoup en commun avec les théoriciens et les praticiens de l'application des connaissances; en fait, les similitudes entre l'application des connaissances intégrée2 (ACi) et l'évaluation axée sur l'utilisation (EAU) sont frappantes au niveau des principes et des approches.

L'ACi et l'EAU :

- accordent une place prédominante à l'utilisation (des résultats de l'évaluation ou de la recherche) à toutes les étapes du processus;

- font la promotion de la recherche et de l'évaluation effectuées en réponse aux besoins des intervenants;

- font la promotion de la participation véritable des utilisateurs prévus de l'activité de recherche ou d'évaluation dès le départ. L'évaluation axée sur l'utilisation préconise l'identification des personnes qui seront censées donner suite aux résultats et se concentre sur les questions d'évaluation qui les intéressent;

- considèrent l'évaluateur / le chercheur comme membre d'une équipe de collaborateurs au regard de l'expérience, des connaissances et des priorités des utilisateurs.

Bien qu'il soit utile de connaître les différentes origines de l'évaluation et les diverses approches en matière d'évaluation, il est aussi important de savoir que de nombreux points communs existent entre ces différentes approches (Shadish, 2006) et que les sociétés d'évaluation s'entendent sur les principes clés de l'évaluation.

Section 2 : Pour commencer

La section précédente présentait un survol des concepts en matière d'évaluation. La présente section est la première de deux qui guident le lecteur étape par étape dans la préparation et l'élaboration d'un plan d'évaluation. Les deux sections fournissent un complément d'information particulièrement utile aux personnes qui effectuent des évaluations concertées ou qui ont des partenaires à l'extérieur du milieu universitaire.

Bien que les activités décrites dans cette section suivent une séquence, vous trouverez sans doute que a) la détermination du but de l'évaluation, b) l'identification des intervenants, c) l'estimation des compétences en évaluation, d) la collecte des données pertinentes et e) l'établissement d'un consensus sont des activités itératives. Tout dépendant de l'évaluation, ces tâches peuvent s'accomplir dans un ordre différent.

Étape 1 : Déterminer les buts de l'évaluation

Une des premières étapes dans la planification des activités d'évaluation est la détermination du but. Il est possible ou même probable que le but de l'évaluation change – parfois de manière importante – sous l'influence d'autres activités préparatoires (p. ex. engagement des intervenants, collecte de renseignements supplémentaires). C'est pourquoi il est préférable de finaliser la sélection du but en collaboration avec les intervenants clés. Cependant, en tant qu'évaluateur, vous devez être au courant des buts potentiels de l'évaluation et être prêt à explorer diverses solutions de rechange.

Comme indiqué précédemment, une évaluation peut viser quatre grands buts :

Porter un jugement sur l'utilité ou le mérite d'un programme ou d'une activité

Il s'agit de la forme d'évaluation (évaluation sommative) la mieux connue. Elle convient lorsqu'un programme est bien établi et qu'il faut prendre des décisions quant à ses impacts, sa poursuite ou son expansion.

- Exemple 1 : Le programme X a été mis à l'essai à l'hôpital Y. Il faut prendre une décision quant à la poursuite du programme.

- Exemple 2 : Un nouveau traitement est expérimenté sur des patients en physiothérapie. L'évaluation vise à déterminer les résultats du traitement sur les patients.

De nombreux chercheurs sont engagés dans des études pilotes (études d'envergure modeste visant à déterminer la faisabilité, la sécurité, l'utilité ou les impacts d'une intervention avant sa mise en œuvre à grande échelle). Ces études visent à déterminer si une initiative a suffisamment de mérite pour justifier qu'elle soit développée, adoptée telle quelle ou étendue à d'autres endroits. Les études pilotes requièrent donc un certain degré d'évaluation sommative – il faut porter un jugement sur au moins un de ces facteurs. Ce qu'on oublie souvent, cependant, c'est que l'évaluation d'une étude pilote peut couvrir autre chose que le mérite – autrement dit, elle n'est pas limitée à ce but précis. Si elle est bien conçue, l'évaluation d'une étude pilote peut cerner des points à améliorer ou explorer des questions concernant la mise en œuvre, la rentabilité ou l'application à grande échelle d'une intervention. Elle peut même proposer des stratégies différentes pour atteindre l'objectif de l'étude pilote.

Améliorer un programme

Lorsqu'un programme est « en construction », il n'est pas encore « mûr » pour une évaluation sommative. Dans ce cas, l'évaluation peut servir à orienter le développement de l'initiative (évaluation formative). Cependant, une approche axée sur l'amélioration peut aussi servir à évaluer une intervention établie. Une évaluation bien conçue dans un but d'amélioration peut fournir sensiblement la même information qu'une évaluation sommative (p. ex. succès d'un programme dans l'atteinte de ses objectifs). La principale différence est que le but est d'améliorer, plutôt que de porter un jugement. Par exemple, le personnel des programmes exprime souvent le désir d'évaluer les programmes afin de s'assurer de faire le « meilleur travail possible ». Son intention (but) est de rehausser la qualité des programmes. Un avantage de l'évaluation axée sur l'amélioration est que, comparativement à l'évaluation sommative, elle tend à être moins menaçante pour les participants et plus susceptible de promouvoir la collaboration dans la recherche de solutions.

- Exemple 1 : Le programme X existe depuis plusieurs années. Bien qu'il ne doute pas de l'utilité du programme, le personnel veut quand même s'assurer qu'il sert le « mieux possible » ses clients.

- Exemple 2 : Le programme Y a été considérablement modifié afin de promouvoir l'autogestion des maladies chroniques par les patients. Les commanditaires de l'évaluation veulent s'assurer que le programme modifié soit correctement mis en œuvre et que tout changement nécessaire aux processus soit apporté avant la mesure des résultats cliniques.

Guider le travail de conception et d'élaboration d'un programme ou d'une structure organisationnelle

L'évaluation de développement prend appui sur les processus d'évaluation (p. ex. poser des questions d'évaluation, appliquer la logique d'évaluation) pour contribuer au développement de programmes, de produits, de ressources humaines et/ou d'organisations. Reflétant les principes de la théorie de la complexité, ce type d'évaluation est utilisé pour soutenir un processus d'innovation continu. L'emploi d'une approche axée sur le développement suppose aussi que les mesures et les mécanismes de surveillance utilisés dans l'évaluation continueront d'évoluer avec le programme. Un fort accent est mis sur la capacité d'interpréter les données issues du processus d'évaluation (Patton, 2006).

Dans l'évaluation de développement, le rôle principal de l'évaluateur, comme membre d'une équipe et non comme ressource externe, consiste à développer l'esprit d'évaluation. Les responsables de la conception et de l'exécution du programme collaborent dans la conception et la mise à l'essai de nouvelles approches dans le cadre de ce processus à long terme d'amélioration, d'adaptation et de changement volontaire continus. Le développement, l'exécution et l'évaluation sont vus comme des activités intégrées qui s'éclairent mutuellement de façon constante.

L'évaluation de développement semble avoir beaucoup en commun avec l'évaluation axée sur l'amélioration. Cependant, dans ce dernier type d'évaluation, une intervention particulière (ou modèle particulier) a déjà été choisie : l'évaluation a pour but d'améliorer ce modèle. En revanche, dans l'évaluation de développement, il y a ouverture à d'autres solutions – même à la révision de l'intervention en réponse aux conditions observées. Autrement dit, l'accent n'est pas mis sur le modèle (programme, produit ou processus), mais sur les objectifs de l'intervention. Une équipe peut tout aussi bien considérer comme un succès une intervention évaluée comme « inefficace », si l'analyse approfondie de cette intervention fournit l'information nécessaire pour s'orienter vers une solution mieux éclairée.

- Exemple 1 : L'agence X a conçu l'intervention Y afin de prévenir la criminalisation des jeunes à risque. Même si l'agence croit que l'intervention est bonne, la littérature renseigne peu sur les solutions efficaces dans ce contexte. Le personnel de l'agence est ouvert à explorer, par l'évaluation, des stratégies autres que l'intervention pouvant contribuer à l'objectif de réduction de la criminalité chez les jeunes.

L'évaluation de développement convient lorsqu'il faut soutenir l'innovation et le développement dans des environnements changeants, complexes et incertains (Patton, 2011; Gamble 2006). Même si beaucoup la considèrent comme une stratégie nouvelle (et potentiellement « à la mode »), l'évaluation de développement ne convient pas à toutes les situations. Premièrement, l'évaluation d'interventions simples ne requiert normalement pas une telle approche (p. ex. évaluer l'exécution d'une intervention jugée efficace dans d'autres contextes). Deuxièmement, les évaluateurs et les commanditaires de l'évaluation doivent être ouverts à l'innovation et flexibles quant à la façon de procéder. Troisièmement, cela requiert une relation continue entre les évaluateurs et l'initiative à évaluer.

Créer de nouvelles connaissances

Enfin, l'évaluation – ou l'étude d'évaluation – peut servir à créer de nouvelles connaissances. Souvent, lorsqu'on demande d'évaluer un programme, une revue critique de la littérature révélera les lacunes des connaissances sur la question ou l'intervention à évaluer. Dans ces cas, les évaluateurs peuvent concevoir l'évaluation avec l'objectif précis de produire des connaissances potentiellement applicables à d'autres contextes – ou de fournir plus d'information sur un aspect particulier de l'intervention.

Même s'il est inhabituel de concevoir une évaluation à cette fin unique (dans la plupart des cas, cela est considéré comme un projet de recherche), il est important que les chercheurs sachent que des activités d'évaluation bien conçues peuvent enrichir la littérature.

Comme le montrent les questions d'évaluation possibles ci-dessous, une évaluation peut évoluer dans des directions très différentes selon son but.

Exemples de but d'évaluation : Étude de cas no 1 : Patients orphelins

- Questions axées sur le jugement : Les modèles de soins atteignent-ils leur objectif? Devrait-on continuer de tous les financer? Un modèle particulier est-il meilleur qu'un autre?

- Questions axées sur l'amélioration : Comment peut-on améliorer les modèles actuels?

- Questions axées sur le développement : Quelle est la meilleure stratégie pour atteindre nos objectifs de continuité des soins aux patients et de réduction de la durée des séjours des patients?

- Questions axées sur les connaissances : Les avantages théoriques de chacun de ces modèles existent-ils en pratique?

Exemples de but d'évaluation : Étude de cas no 2 : Aide à la décision automatisée

- Questions axées sur le jugement : Le logiciel devrait-il être adopté dans toute la région? Devrait-on en faire la promotion/mise en marché à plus grande échelle?

- Questions axées sur l'amélioration : Comment peut-on améliorer le logiciel? Comment devrait-on faciliter l'implantation de ces changements de processus et de pratiques?

- Questions axées sur le développement : Quelle est la meilleure stratégie pour assurer la prescription de tests appropriés?

- Questions axées sur les connaissances : Que peut-on apprendre sur les habitudes de prescription de tests par les médecins et sur les facteurs qui facilitent et entravent la modification de ces habitudes?

Étude de cas no 1 : Patients orphelins

Dans cette étude de cas, un ministère provincial de la Santé souhaitait initialement obtenir une évaluation sommative (c.-à-d. voulait savoir quel modèle fonctionnait « le mieux »). Cela impliquait (explicitement ou non) que les résultats serviraient à guider les décisions financières et stratégiques (p. ex. implantation du meilleur modèle dans tous les hôpitaux financés).

Cependant, dans ce cas, les activités préliminaires ont permis de déterminer que :

- la revue systématique de la littérature ne renseignait pas clairement sur le modèle souhaitable dans ce contexte particulier;

- l'activité d'évaluation proposée causait beaucoup d'anxiété aux participants, et les hôpitaux la voyait comme une tentative d'imposer un modèle uniforme à tous les établissements.

On craignait également que l'accent mis sur les « modèles de soins » ne fasse négliger des problèmes systémiques plus vastes soupçonnés d'influer sur les questions que les modèles étaient censés résoudre, et on doutait que l'évaluation tiendrait compte de toute l'information importante pour les différents programmes.

C'est pourquoi les évaluateurs ont proposé une évaluation axée sur l'amélioration (c.-à-d. exploration des moyens d'améliorer les modèles) plutôt qu'une évaluation sommative. Cette recommandation a été acceptée, ce qui a permis aux évaluateurs d'obtenir plus facilement l'appui et la participation du personnel du programme dans un environnement très politique. De plus, en reconnaissant le besoin de produire des connaissances dans un domaine où il y en avait peu à l'époque, les évaluateurs ont pu concevoir l'évaluation de façon à maximiser la création de connaissances. À la fin, un volet « recherche » explicite, soutenu par des fonds de recherche, est venu se greffer à l'évaluation.

Une évaluation peut remplir plus qu'un but, mais il est important que l'intention sous-jacente soit claire. Comme l'exemple ci-dessus le démontre, le but d'une évaluation peut évoluer durant les phases préparatoires.

Étape 2 : Identifier les utilisateurs prévus de l'évaluation

Le concept « d'utilisateur prévu » (souvent appelé intervenant « clé » ou « principal ») est important en évaluation et recoupe celui « d'utilisateur des connaissances » en application des connaissances (L'application des connaissances : définition). Dans la planification d'une évaluation, il est important de distinguer les utilisateurs prévus (ceux qui, vous l'espérez, donneront suite aux résultats de l'évaluation) des intervenants (parties intéressées ou concernées) en général. Les parties intéressées et concernées sont celles qui se préoccupent de la question d'évaluation et de vos résultats ou qui en subiront les effets. Dans le domaine de la santé, il s'agit souvent des patients et de leurs familles, ou parfois du personnel. Des collectivités entières peuvent aussi être concernées. Cependant, tout dépendant des questions d'évaluation, toutes les parties intéressées ou concernées ne peuvent donner suite aux conclusions. Par exemple, les utilisateurs de l'évaluation d'un nouveau service ont moins de chances d'être des patients (tout autant qu'on pourrait le souhaiter) que des cadres supérieurs et des bailleurs de fonds.

Les expériences et les préférences des parties intéressées doivent être intégrées à l'évaluation pour que celle-ci soit crédible. Cependant, ces parties ne sont souvent pas le principal public visé par les conclusions de l'évaluation. Leur participation peut consister à s'assurer (par exemple) que l'évaluation comporte un examen systématique de l'expérience des patients/familles ou des fournisseurs. Cependant, en fonction de l'initiative, ces patients ou membres du personnel ne sont pas nécessairement responsables d'agir en réponse aux résultats de l'évaluation. Le public visé (celui qui doit donner suite aux conclusions) n'est peut-être pas le personnel, mais plutôt un cadre supérieur ou un bailleur de fonds provincial.

Il est important de garder à l'esprit les avantages d'engager de façon véritable les utilisateurs prévus de l'évaluation, dès les étapes initiales. Comme nous l'apprend la littérature, une des stratégies clés pour combler l'écart entre la recherche et la pratique consiste à lier aux conclusions de l'évaluation (appropriation) les gens qui sont en position d'y donner suite (Cargo & Mercer, 2008). Cela ne veut pas dire que ces personnes doivent être incluses dans tous les aspects de la recherche (p. ex. collecte de données), mais qu'au moins elles participent à la sélection des questions d'évaluation et à l'interprétation des données. De nombreux évaluateurs pensent que la meilleure stratégie pour ce faire est de créer un comité de direction/planification chargé de guider l'évaluation – et de le concevoir de façon à assurer la participation de tous les intervenants clés.

Les bailleurs de fonds (actuels ou futurs) peuvent figurer parmi les plus importants publics d'une évaluation, car ce sont eux qui décideront de poursuivre ou non le financement de l'initiative. Prenons par exemple un projet pilote ou de démonstration financé avec des fonds de recherche. Il peut être relativement aisé de gagner le soutien d'un gestionnaire de la santé (ou de la haute direction d'une région sanitaire) pour obtenir le site d'un programme pilote ou d'une innovation si les fonds nécessaires proviennent d'une subvention de recherche. Si, par contre, on espère qu'une évaluation positive se traduira par l'adoption à long terme de l'initiative, il est sage de s'assurer que les gens placés pour prendre cette décision sont totalement engagés dans la conception de l'évaluation et que les questions couvertes dans l'évaluation soient d'intérêt et d'importance pour eux.

Étape 3 : Créer une structure et un mécanisme de collaboration à l'évaluation

Après l'identification des intervenants, les évaluateurs doivent s'attaquer au travail pratique de création d'une structure et d'un mécanisme de collaboration. Lorsque c'est possible, on conseille de confier ce rôle à un groupe existant pouvant s'en charger. Comme les gens sont toujours occupés, il peut être plus facile d'ajouter une fonction de direction à des activités existantes.

Dans d'autres cas, il peut être nécessaire de créer une nouvelle entité, surtout si les groupes et les points de vue sont variés. La création d'un comité de direction neutre (et la reconnaissance officielle du rôle et de l'importance de chaque intervenant en invitant chacun à y siéger) est peut-être la meilleure stratégie dans ces cas. Quelle que soit la structure choisie, il faut être respectueux de l'investissement en temps demandé aux intervenants, et en faire un usage judicieux.

Dans l'établissement de votre plan d'évaluation, une autre stratégie importante est de tenir compte des coûts des intervenants. Ces coûts varient selon la provenance des intervenants (c.-à-d. communautés locales ou systèmes de santé/services sociaux plus vastes). L'important est de se rappeler que ces intervenants clés (utilisateurs prévus de l'évaluation), tout comme les utilisateurs des connaissances en recherche, ne désirent pas simplement servir de « sources d'information ». Pour investir leur temps dans l'évaluation, ils ont besoin de savoir qu'ils seront des partenaires respectés, que leur expertise sera reconnue et que leur organisation en tirera des avantages. Comme principe général, les « coûts » de toutes les parties contribuant à l'évaluation devraient être reconnus et – dans la mesure du possible – remboursés. Ce remboursement n'a pas besoin d'être en espèces. Le respect et la reconnaissance peuvent aussi s'exprimer par :

- la participation aux décisions, notamment sur la détermination du but, de l'objet et des questions de l'évaluation;

- la création d'une structure de comité de direction reconnaissant officiellement la valeur accordée aux partenaires dans le processus d'évaluation;

- la mesure dans laquelle il y a communication multidirectionnelle entre l'équipe d'évaluation et les gens de l'initiative à évaluer.

Si les intervenants clés sont des soignants de première ligne dans le système de santé, il sera difficile de garantir leur participation à moins que les coûts de réaffectation de leurs fonctions soient remboursés à l'organisation. De même, les médecins dans des postes non administratifs peuvent s'attendre à être dédommagés pour leur perte de revenus.

Vous vous demandez peut-être combien de temps requiert la mise sur pied d'un tel comité, le maintien des communications et la participation aux réunions. Cela demande un certain temps, mais vous en tirerez les avantages suivants :

- démonstration de respect envers les utilisateurs prévus de l'évaluation;

- crédibilité (et qualité) accrue de l'évaluation;

- probabilité beaucoup plus élevée que l'on donnera suite aux résultats de l'évaluation.

Il est particulièrement important d'établir un comité de direction si vous travaillez dans une culture qui vous est étrangère (culture organisationnelle, communauté culturelle ou domaine/question que vous connaissez peu). Vous assurer que le comité de direction/planification inclut des personnes dotées des connaissances culturelles requises constitue un des moyens de faciliter une évaluation culturellement « compétente » et attentive aux sensibilités associées au travail dans un contexte particulier.

Il n'est peut-être pas possible de faire participer en même temps tous les membres d'un comité de concertation, surtout si vous incluez des cadres supérieurs. Il peut même être inopportun de réunir tous les utilisateurs prévus de l'évaluation (p. ex. bailleurs de fonds) avec d'autres intervenants. Cela dit, toutes les personnes que vous avez espoir d'intéresser et de faire réagir aux conclusions de l'évaluation doivent être engagées par au moins les trois moyens suivants :

- contribution à la formulation des questions d'évaluation;

- réception de mises à jour régulières sur les progrès. Un plan de communication bien conçu (assurant une communication bidirectionnelle à mesure que l'initiative progresse et que les conclusions émergent) est nécessaire;

- participation à l'interprétation des résultats et de leurs implications sur les mesures à prendre.

Il est aussi essentiel que les évaluateurs principaux fassent partie de ce comité de direction, même si – tout dépendant de la composition de votre équipe (étape 4) – la présence de tous ceux qui contribuent à l'évaluation n'est peut-être pas nécessaire à chaque réunion.

Étape 4 : Évaluer les capacités d'évaluation, former une équipe d'évaluation

Un des principaux défis est de vous assurer que votre équipe possède l'expertise nécessaire en évaluation afin de :

- concevoir le volet « évaluation » de votre proposition;

- négocier les aspects relatifs à l'environnement et aux communications avec les intervenants;

- guider et effectuer les activités d'évaluation.

Une erreur commune des chercheurs est de présumer que leur équipe de recherche dispose déjà des compétences voulues en évaluation. Parfois, l'évaluation par les pairs révèlera au sein de cette équipe une expertise limitée en évaluation ou l'absence des compétences en évaluation nécessaires pour le plan d'évaluation proposé. Par exemple, un plan d'évaluation fondé sur une appréciation des perspectives du personnel ou des patients sur une innovation requiert la présence d'un spécialiste en recherche qualitative au sein de l'équipe. Rappelez-vous qu'il faut connaître la « culture » où se déroule l'évaluation et en avoir l'expérience, posséder des compétences de base en communication et en négociation, et être sensible aux dimensions politiques. Vous renforcerez votre proposition en vous assurant que votre équipe possède toute l'expertise voulue pour l'évaluation particulière que vous proposez. Ne comptez pas simplement sur l'embauche d'un consultant en évaluation arrivant dans votre équipe en cours de route.

Revoir la composition de votre équipe d'évaluation est une activité itérative – à mesure que vous avancerez dans votre plan d'évaluation, vous pourrez constater le besoin d'ajouter des questions d'évaluation (et par conséquent de diversifier les méthodes employées). Cela pourra vous obliger à réexaminer votre expertise.

Évaluateurs internes ou externes

La littérature dans le domaine de l'évaluation fait souvent la distinction entre évaluateurs « internes » et « externes ». Les évaluateurs internes sont ceux qui font déjà partie de l'initiative (employés du système de santé ou chercheurs). Les évaluateurs externes n'ont pas de lien avec l'initiative à évaluer. Il est fréquent de recommander des évaluateurs internes pour l'évaluation formative, et des évaluateurs externes pour l'évaluation sommative.

Le tableau suivant résume les différences communément relevées entre les évaluateurs internes et externes.

| Interne | Externe | |

|---|---|---|

| Avantages |

|

|

| Désavantages |

|

|

Cela dit, cette dichotomie interne-externe est un reflet trop simpliste de la réalité de nombreuses évaluations et n'assure pas – en soi – le respect des principes d'intégrité et de compétence en évaluation. Elle ne reconnaît pas non plus l'existence possible d'autres solutions plus créatives. Trois stratégies potentielles pour profiter des avantages de l'évaluation interne et externe sont décrites en détail ci-dessous :

Opter pour une approche concertée, dans laquelle les évaluateurs sont inclus avec les intervenants comme membres de l'équipe. Il s'agit d'une pratique courante dans de nombreux types d'évaluation concertée, et d'un élément essentiel d'une évaluation de développement ou axée sur l'utilisation. Certains évaluateurs font la différence entre une évaluation objective (qui suppose un certain degré d'indifférence à l'égard des résultats) et une évaluation neutre (qui signifie que l'évaluateur est impartial) (Patton, 1997). Les approches concertées sont de plus en plus communes, ce qui reflète une conscience des avantages de la recherche et de l'évaluation concertées.

Déterminer les éléments particuliers de l'évaluation nécessitant une expertise externe (pour ajouter de la crédibilité ou des compétences), et intégrer des évaluateurs internes et externes dans le plan d'évaluation. Une évaluation (formative ou sommative) requiert une expertise externe dans les cas suivants :

- Exploration des perspectives des participants (p. ex. personnel et/ou patients). Par exemple, il n'est pas recommandé que le personnel ou les gestionnaires d'un programme interrogent les patients sur leur degré de satisfaction à l'égard d'un service, et ce afin d'assurer la rigueur de l'évaluation (éviter que les patients ou le personnel donnent les réponses attendues d'eux – biais de désirabilité sociale) et le respect des normes éthiques. Le principe de participation « volontaire » peut être compromis si les patients se sentent obligés de participer parce que la demande vient du fournisseur d'un service dont ils dépendent.

- Éviter à l'évaluateur un conflit d'intérêts potentiel (ou apparent). Les raisons de ne pas faire appel au gestionnaire d'un programme pour en faire l'évaluation sont généralement évidentes, mais il faut aussi tenir compte du risque de biais de la part des chercheurs. Si ces derniers ont conçu et proposé l'intervention, ils peuvent chercher, consciemment ou non, à conclure à son succès.

- Lorsqu'il n'existe pas à l'interne l'expertise nécessaire pour un aspect particulier.

- Lorsque l'utilisation d'une personne ou d'un groupe particulier nuirait à la crédibilité des résultats aux yeux d'un intervenant clé.

Les activités qui se prêtent bien à une évaluation interne sont celles pour lesquelles on dispose à l'interne des compétences et du temps requis et pour lesquelles l'emploi de ressources internes n'influencera pas la crédibilité de l'évaluation. Un exemple pourrait être la collecte et la compilation de données descriptives sur un programme. Dans certains cas, une bonne idée pourrait être d'embaucher un statisticien à forfait pour obtenir l'expertise spécialisée et de faire appel aux analystes internes pour produire les rapports de données.

Faire appel à des ressources internes sans lien avec l'initiative à évaluer Un exemple classique pourrait être de confier l'évaluation (ou certaines de ses parties) à l'unité de recherche et d'évaluation d'une organisation. Même s'il ne s'agit pas d'une évaluation externe (et même si cette solution risque de ne pas être optimale dans un contexte très politisé), cela conjugue souvent les avantages suivants :

- Connaissance du contexte, ce qui permet une économie de temps et une meilleure compréhension des impacts potentiels et des facteurs confusionnels.

- Engagement envers l'intérêt primordial de l'organisation, et non de celui d'un programme particulier (c.-à-d. potentiel d'objectivité).

- Possibilité de promouvoir l'utilisation appropriée des résultats, à la fois de façon directe et, s'il y a lieu, par la collaboration avec d'autres initiatives ailleurs dans l'organisation.

Étape 5 : Recueillir les données pertinentes

Le programme, le produit, le service, la politique ou le processus que vous évaluerez existe dans un contexte particulier. La compréhension du contexte est essentielle à la plupart des activités d'évaluation : un travail préparatoire à l'évaluation est nécessaire pour déterminer l'historique de l'initiative, le public concerné par l'initiative, les perspectives et les préoccupations des intervenants clés et le contexte général entourant l'initiative (p. ex. contexte organisationnel et stratégique). Comment l'initiative a-t-elle vu le jour? A-t-elle déjà été évaluée par le passé? Qui préconise l'évaluation à ce moment précis et pourquoi?

De plus, avant de commencer une évaluation, il est habituellement nécessaire de vérifier la littérature relative aux questions à l'étude. La détermination, la collecte et l'utilisation des données utiles à une évaluation constituent une importante contribution de la recherche. Cette vérification peut s'attarder à :

- l'état de la recherche existante sur les questions liées à l'initiative à évaluer. De nombreuses interventions sont mises sur pied organiquement sans être éclairées par la recherche. De plus, même si l'initiative a été éclairée par la recherche dans le passé, le personnel du programme peut ignorer les derniers travaux dans le domaine;

- l'évaluation d'initiatives similaires.

Dans le cas d'une évaluation potentiellement controversée, il convient aussi souvent de rencontrer individuellement chacun des intervenants afin de les inciter à faire connaître franchement leurs perspectives.

Étude de cas no 1 : Patients orphelins

La première étape de cette évaluation a consisté en une revue de la littérature. Même si on espérait qu'une revue systématique fasse pencher vers un certain modèle, cela n'a pas été le cas – la littérature pertinente abordant les questions dans ce contexte particulier était pratiquement inexistante. La présentation de cette conclusion à une réunion des intervenants a aussi révélé certaines tensions et divergences de vues entre les intervenants.

Une des étapes suivantes proposées par les évaluateurs a été de visiter chacun des sites. Ces visites, incluant un survol des programmes et des rencontres avec la direction du personnel médical et infirmier, ont permis d'accomplir deux choses : a) collecte d'information complémentaire sur les « rouages » qui aurait été difficile à obtenir autrement; et b) développement d'une relation avec le personnel – qui a apprécié le fait de pouvoir contribuer à l'évaluation et décrire le contexte général entourant la prestation des services.

Étude de cas no 2 : Aide à la décision automatisée

Une revue de la littérature a renseigné sur a) les principes clés pour prédire l'adoption efficace, b) l'importance des activités d'exécution et c) l'information limitée sur les impacts de l'aide à la décision automatisée dans ce secteur médical particulier. Cette information a justifié davantage la décision de a) se concentrer sur l'évaluation de l'exécution; et b) greffer un volet qualitatif explorant les perspectives des utilisateurs au plan initial de mesure des tests prescrits avant/après l'intervention.

Étape 6 : Bâtir un consensus autour de l'évaluation

Comme expliqué aux sections précédentes, l'évaluation fait l'objet de certaines idées fausses et peut avoir divers buts et approches. On peut généralement présumer, sans trop craindre de se tromper, que les intervenants n'auront pas tous la même perception de ce qu'est une évaluation, ni la même idée de la meilleure façon d'évaluer ce qui doit l'être. L'évaluation causera probablement une certaine anxiété ou inquiétude chez certains.

C'est pourquoi il est important de s'entendre et de développer une interprétation commune avant le début de l'évaluation. De nombreux évaluateurs trouvent utile d'intégrer à la planification une séance d'initiation couvrant les points suivants :

- Définition de l'évaluation, similitudes et différences entre évaluation, gestion du rendement, amélioration de la qualité et recherche;

- Variété des buts possibles d'une évaluation, et information sur les situations correspondant à chacun. Si l'évaluation est source d'anxiété, il est particulièrement important de présenter l'éventail complet des choix possibles et d'aider les participants à comprendre que l'évaluation – au lieu de constituer un jugement sur leur travail – peut en fait les aider et leur servir de ressource;

- Principes et avantages de l'évaluation concertée;

- Façon de préserver la confidentialité;

- Processus proposé pour l'élaboration du plan d'évaluation.

Ce survol peut être aussi bref qu'une vingtaine de minutes au besoin. Il permet à l'évaluateur d'aborder de façon proactive de nombreuses idées fausses possibles, lesquelles peuvent influer négativement sur a) le soutien et la participation à l'évaluation et b) l'intérêt à donner suite aux conclusions de l'évaluation. Les autres avantages de cette approche incluent l'occasion de développer les capacités parmi les intervenants de l'évaluation et de commencer à établir un climat propice à la collaboration dans la recherche de solutions.

Il est aussi important de s'assurer que les paramètres de l'évaluation sont bien définis. Souvent, les divers intervenants engagés dans le processus d'évaluation ne s'entendent pas sur ce qui est couvert par l'évaluation. Le fait d'établir un consensus à ce sujet dès le début aide à fixer des objectifs d'évaluation clairs et à gérer les attentes des intervenants. Ce consensus initial vous aidera, vous et vos partenaires, à vous assurer que la portée de l'évaluation ne devient pas irréaliste dans l'élaboration du plan d'évaluation. Les stratégies pour établir l'objet d'une évaluation et prioriser les questions d'évaluation sont examinées aux étapes 8 et 9.

Étude de cas no 1 : Patients orphelins

Dans cet exemple, la séance d'initiation à l'évaluation a été intégrée aux visites des sites. Les thèmes clés ont été intégrés à la version initiale du projet d'évaluation, qui a été partagée avec tous les sites aux fins de rétroaction. Cela a eu pour résultat que même si les membres des trois établissements ne s'étaient jamais rencontrés, ils ont pu développer une perception commune de l'évaluation et s'entendre sur ses modalités.

Vous constaterez peut-être que les activités de création de consensus cadrent bien dans une réunion initiale des partenaires de votre évaluation. Dans d'autres cas, il vaut peut-être mieux tenir ces discussions une fois que tous les intervenants sont connus.

Questions spéciales liées à l'évaluation concertée

Dans l'évaluation concertée avec des organismes externes, il est aussi important de clarifier les rôles et les attentes tant des chercheurs que du personnel et des gestionnaires du programme, et de décrire en détail les contributions en temps et les exigences liées à l'accès aux données. Il est particulièrement important de s'entendre clairement sur l'accès aux données, la gestion et le partage des données (y compris sur le lieu et le moment où les partenaires y auront accès) avant le début de l'évaluation.

Avant de s'engager dans une évaluation, il est aussi important de clarifier quelle information sera rendue publique par l'évaluateur. Les intervenants doivent savoir que les résultats des évaluations financées par des fonds de recherche sont transmis au public. De même, le personnel doit savoir que les cadres supérieurs auront le droit de voir les résultats des évaluations financées par l'organisme client.

Il est aussi important d'aborder de façon proactive les questions liées à la communication des résultats de l'évaluation. Il peut arriver qu'un organisme commanditaire choisisse – de crainte d'être déçu par le rapport d'évaluation – de présenter une version préliminaire (et plus positive) des conclusions avant la publication du rapport final. Il peut même parfois refuser de communiquer les résultats. C'est pourquoi il est important de définir clairement les rôles et de préciser que l'évaluateur est le porte-parole autorisé de l'évaluation et le seul à pouvoir en rapporter les conclusions de façon exacte, accepter des invitations à en parler ou les publier. (Il est encore mieux de préparer et de présenter les résultats en collaboration avec les intervenants.) De même, il revient aux responsables du programme/organisme de parler des questions particulières liées à la conception du programme.

Des lettres d'engagement clair de la part des partenaires de recherche et d'évaluation ont pour effet de renforcer les propositions de recherche comportant un volet « évaluation ». Ces lettres devraient préciser la nature et l'étendue de la participation des partenaires à l'élaboration de la proposition; la structure et les mécanismes appuyant les activités de collaboration; et les engagements et les contributions des partenaires aux activités d'évaluation proposées (p. ex. accès aux données, contribution en nature sous forme de services).

Étape 7 : Décrire le programme / l'intervention

Remarque spéciale : Même si cette activité est classée dans la section sur la préparation, de nombreux évaluateurs estiment, en pratique, qu'il peut être compliqué d'obtenir une description claire du programme et du mécanisme par lequel il est censé fonctionner. Il est souvent nécessaire de reporter cette activité plus tard dans le processus de planification, car vous aurez peut-être besoin de la participation active des intervenants clés pour vous faciliter cette tâche souvent ardue.

Un certain nombre de raisons expliquent pourquoi il est utile de faire décrire le programme par les intervenants :

- il s'agit peut-être de la première fois depuis un certain temps que les intervenants ont l'occasion de réfléchir au programme, à son fondement logique et aux données probantes qui en éclairent la conception;

- les visions différentes du fonctionnement pratique du programme feront rapidement surface;

- cela peut aider à clarifier la base théorique du programme.

Cela dit, vous constaterez peut-être que les responsables de la gestion du programme considèrent comme une tâche fastidieuse de décrire sur papier leur programme ou initiative. Un rôle important de l'évaluateur peut être de faciliter cette activité.

Étude de cas no 1 : Patients orphelins

Un des livrables exigés par le ministère provincial de la Santé était une description du fonctionnement de chacun des modèles. Cette activité préliminaire a nécessité plus de six mois; chaque fois qu'on faisait circuler une ébauche pour commentaires, les intervenants ajoutaient de l'information et exprimaient leur divergence de vues sur la façon dont les choses fonctionnaient vraiment dans la pratique.

Modèles logiques

De nombreux évaluateurs attachent une grande importance aux modèles logiques. Les modèles logiques montrent l'enchaînement logique des activités pour illustrer ce que l'intervention vise à accomplir. Ainsi, les modèles logiques cadrent avec l'évaluation à base théorique, puisque l'intention est d'entrer dans la « boîte noire » et d'articuler le fondement théorique d'un programme. Les chercheurs connaissent mieux les modèles ou cadres « conceptuels », et il existe de nombreuses similitudes entre les deux. Cependant, un cadre conceptuel est généralement plus théorique et conceptuel qu'un modèle logique, qui tend à être adapté à un programme particulier et à détailler davantage les activités de ce programme.

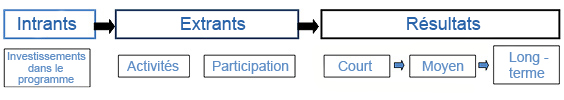

Lorsqu'ils sont bien conçus, les modèles logiques illustrent les « si-alors » et les liens de causalité entre les composantes du programme et ses résultats, et peuvent lier la planification, l'exécution et l'évaluation des programmes. Ils peuvent être d'une grande utilité pour faciliter une réflexion claire et articuler le fondement théorique du programme. Les modèles logiques existent dans différents formats, allant du graphique linéaire au tableau multidimensionnel complexe. Le plus simple montre l'enchaînement logique des activités sous les titres « intrants » (ce qui est investi dans l'initiative), « extrants » (les activités et les participants) et « résultats » (à court, moyen et long terme).

D'autres modèles logiques sont plus élaborés et illustrent des relations multidirectionnelles complexes. Voir, par exemple, les différents modèles conçus par l'Université du Wisconsin (en anglais seulement).

Malgré leur popularité, les modèles logiques peuvent avoir certaines limites et ne constituent pas la seule stratégie pour clarifier la théorie sous-jacente à l'intervention à évaluer.

Trop souvent, les modèles logiques sont vus comme une nécessité bureaucratique (p. ex. exigence du bailleur de fonds), et on se préoccupe alors uniquement de « remplir les cases » au lieu d'articuler le fondement théorique du programme et la justification des hypothèses du modèle. Autrement dit, plutôt que de promouvoir l'esprit d'évaluation, le processus de conception du modèle logique peut avoir pour effet de l'inhiber. Une autre faiblesse potentielle des modèles logiques est leur tendance à se baser sur l'hypothèse d'une relation linéaire logique entre les composantes et les résultats d'un programme, ce qui ne reflète pas la complexité du contexte de nombreuses interventions. Parfois les modèles logiques peuvent même promouvoir une réflexion simpliste (sans originalité). Selon certains auteurs, les modèles logiques ne conviennent pas aux évaluations dans des environnements complexes (Patton, 2011).

Que l'on se serve ou non des modèles logiques comme outils de planification d'une évaluation, il est important de pouvoir articuler le fondement théorique du programme : les mécanismes par lesquels le changement est censé se produire. Une description du programme, comme indiqué plus haut, est un premier pas dans cette direction. Parfois, le fondement théorique s'exprime mieux de façon textuelle par la description des liens entre chaque composante du programme/processus. (En raison des preuves solides sur X, nous avons conçu l'intervention Y). Cette approche a aussi l'avantage de créer une structure facilitant l'inclusion des données disponibles appuyant la théorie de l'action proposée.

Résumé

Il est probable que les activités décrites dans cette section, même si elles sont présentées de façon séquentielle, se déroulent de façon simultanée. L'information recueillie par chacune des activités guidera les autres (et fera souvent ressortir le besoin de les réviser). Il est important de compléter ces activités préliminaires avant de passer à l'élaboration du plan d'évaluation.

Section 3 : Concevoir une évaluation

Les étapes décrites dans cette section peuvent être parcourues très rapidement si le travail préparatoire recommandé à la section 2 est terminé. Idéalement, vous mènerez ces activités de planification en collaboration avec votre groupe de direction/planification.

Matrice de planification d'une évaluation

Pour les prochaines étapes, le module sera basé sur une matrice de planification d'une évaluation (annexe A). Cette matrice ne se veut pas un modèle d'évaluation, mais plutôt un outil pour organiser votre planification. Les modèles doivent être utilisés avec prudence en évaluation, car une étude d'évaluation est beaucoup plus qu'une activité technique. Cela requiert une réflexion critique, un jugement sur les données probantes, une analyse rigoureuse et une maîtrise des concepts.

La première page de la matrice vise simplement à documenter a) le contexte de l'initiative, b) le but de l'évaluation prévue, c) l'utilisation prévue de l'évaluation, d) les intervenants clés (utilisateurs prévus de l'évaluation), e) l'objet de l'évaluation. L'exécution du travail préparatoire devrait vous permettre de terminer les sections a) à d).

Cette section examine d'abord l'objet (étape 8, ci-dessous) et passe en revue les étapes à franchir pour remplir la page 2 de la matrice (étapes 9 à 11). L'annexe B fournit un exemple de matrice terminée pour l'étude de cas no 1 : Patients orphelins.

Étape 8 : Confirmer le but, établir l'objet de l'évaluation

Confirmer le but de l'évaluation

Les activités préparatoires vous ont permis de clarifier le but général de l'évaluation. À ce stade, il est utile d'opérationnaliser le but en en faisant une description claire et brève pour mener cette évaluation particulière. Cet énoncé du but, d'une longueur d'un ou deux paragraphes, devrait guider votre planification.

Il est aussi important d'énoncer clairement l'utilisation envisagée (devrait se baser sur les discussions préparatoires avec les intervenants) et les utilisateurs prévus de l'évaluation.

Étude de cas no 1 : Patients orphelins

La renégociation du but de l'évaluation des modèles de soins en milieu hospitalier a abouti à la définition suivante du but :

- Déterminer, à la demande du gouvernement provincial, si les modèles conçus par les sites a) sont efficaces pour fournir les soins aux patients orphelins et b) sont viables. (Vous remarquerez que même si la structure de l'évaluation est axée sur l'amélioration, il y a un engagement à porter un jugement (donner une valeur) relativement à ces deux critères, acceptables à toutes les parties.)

- Explorer les questions liées à la fois au programme particulier et au système pouvant nuire à la prestation de soins de qualité en temps opportun aux patients. Cet objectif reflète la préoccupation, exprimée lors des rencontres préliminaires, à savoir qu'il faut se pencher sur des questions systémiques non limitées à des programmes particuliers.

Conformément à l'approche d'évaluation axée sur l'amélioration, l'intention n'est pas de choisir « le meilleur modèle », mais plutôt de cerner les forces et les limites de chaque stratégie, dans le but de contribuer à l'amélioration de la qualité de tous les modèles de services.